Transformer sind fortschrittliche Modelle des maschinellen Lernens, die vor allem in der Verarbeitung natürlicher Sprache (Natural Language Processing, NLP) und anderen Bereichen des Deep Learning eine zentrale Rolle spielen. Ihre einzigartige Architektur basiert auf dem Prinzip der „Attention“, welches es dem Modell erlaubt, wichtige Teile einer Eingabesequenz – wie etwa Wörter in einem Satz – zu identifizieren und den Fokus entsprechend anzupassen. Diese Technik ermöglicht es Transformer-Modellen, Zusammenhänge innerhalb großer Datenmengen effizient zu erkennen und zu interpretieren.

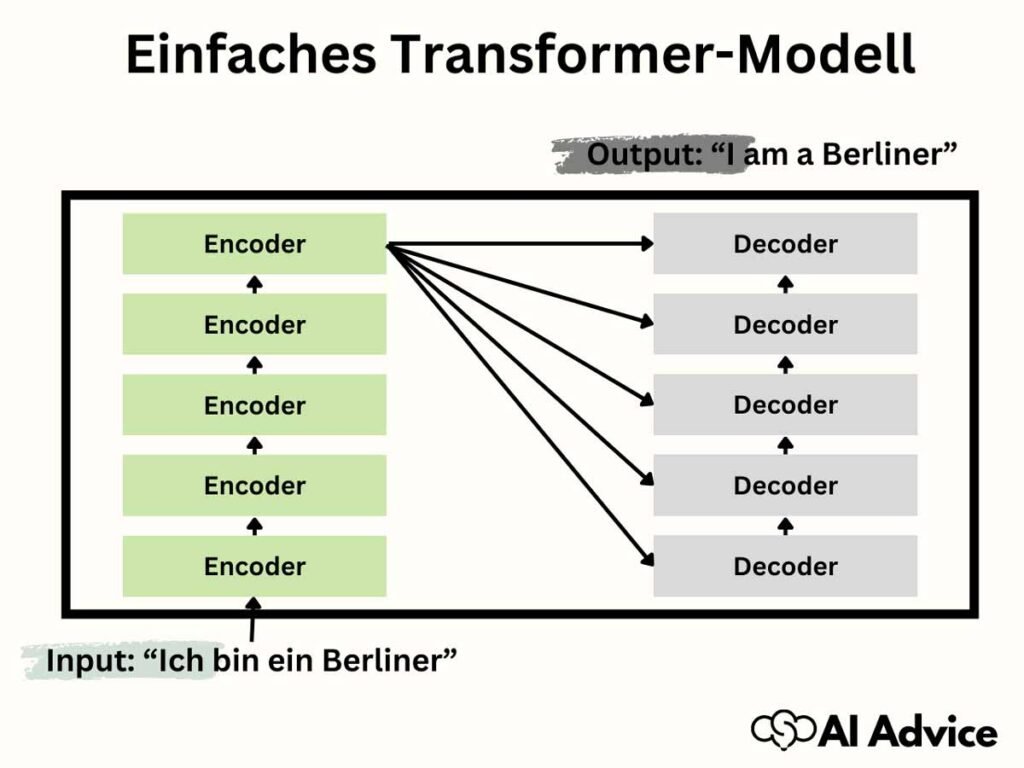

Die Hauptkomponenten eines Transformer-Modells sind der Encoder und der Decoder. Der Encoder verarbeitet die Eingabe und wandelt sie in eine interne Repräsentation um, während der Decoder diese Repräsentation nutzt, um eine Ausgabe zu erzeugen, beispielsweise die Übersetzung eines Textes in eine andere Sprache. Deutsche Forscher spielten eine wichtige Rolle in der Entwicklung dieser Technologie, insbesondere durch das prägende Paper „Attention is All You Need“. Interface-Modelle wie GPT und BERT sind bekannte Varianten von Transformer-Modellen, die durch vorheriges Training auf umfangreichen Daten effektiv Muster erkennen und für verschiedenste Anwendungen in der KI genutzt werden können.

Kernaussagen

- Transformer sind zentral für die Fortschritte in NLP und verschiedenen Deep Learning-Bereichen.

- Sie basieren auf dem „Attention“-Mechanismus, der eine fokussierte Verarbeitung von Information ermöglicht.

- Modelle wie GPT und BERT sind Beispiele für die Anwendung von Transformer-Architektur und zeigen deren Leistungsfähigkeit.

Wie funktionieren Transformer-Modelle?

Transformer-Modelle revolutionieren die Verarbeitung von natürlichen Sprachen, indem sie komplexe Zusammenhänge und Bedeutungen innerhalb von Texten erfassen.

Die Grundprinzipien der Transformer-Architektur

Die Architektur eines Transformers beruht auf einem Encoder-Decoder-Modell. Encoder wandeln Ihren Eingabetext in Vektoren um, die den Kontext jeder Position im Satz darstellen. Die Decoder verwenden diese Vektoren, um Schritt für Schritt eine Ausgabesequenz zu erzeugen. Anders als bei älteren Modellen arbeitet der Transformer komplett ohne rekurrente Schleifen (wie bei RNNs) oder Faltungsschichten (wie bei CNNs).

Warum ‚Attention is all you need‘ das Spiel verändert hat

Das ‚Attention‘-Mechanismus ermöglicht es dem Transformer, die Aufmerksamkeit auf spezifische Teile des Satzes zu lenken, die für die aktuelle Wortvorhersage relevant sind. Dies bedeutet, dass das Modell Zusammenhänge zwischen weit entfernten Worten in einem Satz erkennen kann, ohne dabei sequentiell vorgehen zu müssen. Diese Fähigkeit ist besonders für NLP-Aufgaben von Vorteil, bei denen der Kontext entscheidend für das Verständnis ist.

Der Vergleich: Transformer vs. traditionelle RNNs und CNNs

Im Vergleich zu RNNs (Recurrent Neural Networks), die Informationen sequenziell verarbeiten, ermöglichen Transformer eine parallele Verarbeitung der Daten. Dies führt zu einer erheblichen Beschleunigung des Lernprozesses. CNNs (Convolutional Neural Networks) hingegen sind zwar effektiv in der Mustererkennung innerhalb eines festen Fensters, aber sie sind weniger optimal für das Verständnis der langen Abhängigkeiten im Text. Transformer-Modelle übertreffen diese traditionellen Ansätze, indem sie eine flexiblere und umfassendere Analyse von sprachlichen Daten bieten.

Die Kernelemente der Architektur von Transformer verstehen

In diesem Abschnitt beleuchten Sie die zwei wesentlichen Säulen der Transformer-Architektur: den Encoder und den Decoder, sowie das Herzstück der Technologie, die Self-Attention-Mechanismen. Diese Elemente sind entscheidend, um zu verstehen, wie Transformer Wörter in einem neuralen Netzwerk verarbeiten.

Die Rolle des Encoders und Decoders in Transformer-Modellen

Der Encoder in einem Transformer-Modell hat die Aufgabe, den eingehenden Text in eine Reihe von Vektoren zu überführen. Dieser Prozess wird als Embedding bezeichnet. Jeder dieser Vektoren repräsentiert ein Wort und speichert Informationen über dessen Bedeutung und Kontext in der Sequenz. In einem typischen Transformer-Modell gibt es mehrere Encoder-Layer, die schrittweise eine komplexere Repräsentation der Eingabesequenz erstellen.

Im Gegensatz dazu nimmt der Decoder die vom Encoder bearbeitete Sequenz entgegen und generiert schrittweise die Ausgabesequenz. Bei Sprachübersetzungsaufgaben wäre dies zum Beispiel der Text in der Zielsprache. Der Decoder nutzt auch das Konzept der Attention, um Abschnitte des Eingabetextes zu fokussieren, die für die Generierung des nächsten Worts relevant sind. Jeder Decoder-Layer besteht dabei aus einem Attention Layer und einer anschließenden Feedforward-Neuralschicht, die zur Vorhersage des nächsten Wortes verwendet wird.

Wie Self-Attention den Kontext von Wörtern interpretiert

Self-Attention ist eine Methode, die es einem Transformer ermöglicht, die Relevanz verschiedener Wörter in einem Satz zu bewerten. Es handelt sich dabei um einen Mechanismus, der jeder Komponente der Eingabedaten, also jedem Wort oder Token, eine gewichtete Bedeutung zuordnet. Durch Self-Attention kann der Transformer Zusammenhänge innerhalb des Satzes erfassen und verstehen, wie ein Wort in Bezug auf andere steht.

Für eine tiefergehende Analyse verwendet der Transformer die Multi-Head Attention. Dieser Ansatz unterteilt den Attention-Mechanismus in mehrere ‚Köpfe‘, wodurch es möglich wird, verschiedene Aspekte der Daten parallel zu verarbeiten und zu analysieren. So kann ein Kopf sich auf die grammatische Struktur konzentrieren, während ein anderer synonyme Begriffe herausfiltert. Zusammen ergeben diese ‚Köpfe‘ ein umfassendes Bild des Textes und ermöglichen präzise Vorhersagen bei der Generierung von Wörtern.

Transformer im Einsatz: Von NLP bis Computer Vision

Transformer-Modelle sind die Fundamente der modernen KI-Forschung und Anwendung, die Sie vor allem in der Natural Language Processing (NLP) und Computer Vision vorfinden.

Anwendungsbeispiele von Transformer-Modellen in der Praxis

Transformer haben Ihre Fähigkeiten in vielfältigen Anwendungsbereichen unter Beweis gestellt. In der NLP unterstützen sie Aufgaben wie automatische Übersetzungen, Textgenerierung und das Verstehen von Sprache (Natural Language Understanding, NLU). BERT (Bidirectional Encoder Representations from Transformers) ist ein Beispiel für ein Transformer-Modell, das vor allem in der Sprachmodellierung Anwendung findet. Es kann Satzkontexte überzeugend interpretieren und stellt deshalb einen Fortschritt für die Suchtechnologie und Textanalyse dar.

Bei der Textgenerierung sind GPT-Modelle (Generative Pre-trained Transformer), wie etwa GPT-3, führend. Sie generieren kohärente und relevante Texte, die fast so wirken, als wären sie von Menschen verfasst. Ihre Anwendung reicht von Chatbots bis zu fortgeschrittenen Assistenzsystemen, die Ihnen zuverlässige Textvorschläge offerieren.

In der Computer Vision haben Transformer-Modelle gezeigt, dass sie ohne die herkömmlichen Convolutional Neural Networks (CNNs) auskommen. Sie bewältigen Herausforderungen wie Bilderkennung und -analyse durch Anpassung ihrer Strukturen, sodass visuelle Inhalte effektiv verarbeitet werden können. Ihre Fähigkeit, wichtige Merkmale aus Bildern herauszufiltern, revolutioniert das Machine Learning in diesem Sektor.

Die Bedeutung von Transformer für die Entwicklung von Sprachmodellen wie BERT und GPT-3

Transformer-Modelle wie BERT und GPT-3 sind essentiell für Fortschritte in der NLP. BERT hat die Art und Weise, wie Sprachmodelle trainiert werden, durch seine bidirektionale Trainingsstrategie verändert und war maßgeblich an der Verbesserung von Methoden für das Verständnis von Sprachnuancen beteiligt. Dies hat die Türen für besseres NLU geöffnet und die Grundlage für fortschrittlichere Dialogsysteme und Suchanfragen geschaffen.

GPT-3, als eines der größten Machine-Learning-Modelle, beeindruckt durch seine Textgenerierungsfähigkeit, welche es ermöglicht, themenrelevante und kontextabhängige Inhalte zu erstellen. Das Modell hat gezeigt, dass es in der Lage ist, eine Vielzahl von Aufgaben zu bewältigen, indem es einfach auf umfangreiche Textdaten trainiert wird, ohne für spezifische Aufgaben angepasst werden zu müssen. Solche Modelle stellen einen Meilenstein in der Entwicklung künstlicher Intelligenz dar.

Einblicke in leistungsstarke Varianten: GPT, BERT und mehr

Sie begegnen zwei der fortgeschrittensten Technologien im Bereich der Verarbeitung natürlicher Sprache (NLP) und Natural Language Understanding (NLU): den Transformer-Modellen GPT und BERT. Diese Modelle nutzen komplexe Mechanismen wie Pretraining und Attention, um Texte nicht nur zu verstehen, sondern auch zu generieren.

Generative Pre-trained Transformer (GPT) – Eine neue Ära generativer Modelle

GPT, kurz für Generative Pre-trained Transformer, hat die Textgenerierung revolutioniert. GPT-Modelle, vor allem das neueste GPT-3, lernen Muster menschlicher Sprache in einem Pretraining-Prozess und erzeugen daraufhin Text, der natürliche Konversationen simulieren kann. Dies wurde durch eine riesige Menge an Textdaten und einem Modell mit Millionen von Parametern erreicht.

- Pretraining: Verwendet unlabeled Daten, um das Modell vorzubereiten.

- Anwendung: Eignet sich hervorragend für Chatbots und Anwendungen, die menschenähnliche Texte generieren sollen.

BERT: Durchbruch in der Verarbeitung natürlicher Sprache (NLP)

BERT, entwickelt von Google, steht für Bidirectional Encoder Representations from Transformers und setzt auf den bidirektionalen Kontext im Text. Im Gegensatz zu seinen Vorgängern, die sequenziell lernen, betrachtet BERT die Beziehung zwischen allen Worten einer Sequenz gleichzeitig (Attention).

- Bidirectional Training: BERT berücksichtigt sowohl links- als auch rechtsstehenden Kontext.

- Anwendung: Wird in Suchmaschinen eingesetzt, verbessert die Genauigkeit von NLU-Aufgaben.

Die Auswirkung von Hugging Face und ChatGPT auf die Zugänglichkeit von Transformer-Modellen

Hugging Face hat dazu beigetragen, Transformer-Modelle wie BERT und GPT über eine Open-Source-Bibliothekzugänglicher zu machen. Dies fördert Innovationen, indem es Entwicklern ermöglicht, ohne große Vorinvestitionen mit diesen Technologien zu arbeiten. ChatGPT ist ein prominentes Beispiel eines auf GPT basierenden Chatsystems, das zeigen kann, wie fortgeschritten Textgenerierung heute ist.

- Hugging Face: Ermöglicht den einfachen Zugang zu Pretrained-Modellen wie DistilBERT.

- ChatGPT: Bietet eine Plattform, um NLP- und NLU-Aufgaben spielerisch zu erlernen und zu testen.

Wie man mit Transformer-Modellen startet

Beim Einstieg in das Training von Transformer-Modellen ist es entscheidend, Sich mit den grundlegenden Schritten vertraut zu machen und die Rolle von vortrainierten Modellen zu verstehen.

Grundlegende Schritte zum Trainieren Ihres ersten Transformer-Modells

Sie beginnen mit der Auswahl eines geeigneten Datensatzes für Ihr spezifisches Problem. Um ein effektives Modell zu trainieren, müssen Ihre Trainingsdaten repräsentativ und umfassend sein. Etablieren Sie eine Verarbeitungspipeline, die folgende Schritte umfasst:

- Tokenisierung: Zerlegen Sie Ihren Text in kleinere Einheiten (Tokens).

- Encoding: Konvertieren Sie diese Tokens in Zahlen, die maschinenlesbar sind.

- Batching: Organisieren Sie Ihre Daten in Batches für eine effiziente Verarbeitung während des Trainings.

Nach der Datenvorbereitung beginnt die Trainingsphase. Wählen Sie eine geeignete Transformer-Architektur aus, je nachdem, ob Sie eine „Encoder-only“, „Decoder-only“ oder „Encoder-Decoder“ (Sequence-to-Sequence) Struktur benötigen. Überwachen Sie während des Trainings die Leistungsfähigkeit des Modells und passen Sie die Hyperparameter entsprechend an.

Die Bedeutung von vortrainierten Modellen und Transfer Learning

Vortrainierte Modelle sind ein entscheidender Baustein im Bereich des Machine Learning und Data Science. Sie ermöglichen es Ihnen, von der Arbeit Anderer zu profitieren und auf einem soliden Fundament aufzubauen. Transfer Learning bezieht sich darauf, ein bereits auf einem großen Datensatz vortrainiertes Modell für Ihre spezifische Aufgabe weiterzuentwickeln. Dieser Prozess, oft als Fine-Tuning oder Feintuning bezeichnet, erlaubt es, das Modell mit kleinerem Datenvolumen und weniger rechnerischen Ressourcen anzupassen.

- Auswahl: Finden Sie ein vortrainiertes Transformer-Modell, das zu Ihrer Anwendung passt.

- Anpassung: Passen Sie das Modell mittels Feintuning auf Ihren spezifischen Datensatz an.

- Effizienz: Nutzen Sie Transfer Learning, um den Trainingsprozess zu beschleunigen und bessere Ergebnisse mit weniger Daten zu erreichen.

Bei der Weiterentwicklung berücksichtigen Sie die Relevanz der Trainingsdaten sowie die Notwendigkeit, die Hyperparameter und die Netzwerkarchitektur zu optimieren.

Die Zukunft der Transformer-Modelle in der KI

Sie stehen an der Schwelle zu einer bahnbrechenden Ära in der Künstlichen Intelligenz (KI), in der Transformer-Modelle eine zentrale Rolle spielen. Diese Modelle treiben die Entwicklung fortschrittlicher Datenverarbeitungs- und Textanalyse-Methoden an und erweitern kontinuierlich das Vokabular der Maschine in Bezug auf Natural Language Understanding.

Neuartige Forschungsrichtungen und Entwicklungstendenzen im Bereich Transformer

Forscher auf dem Gebiet des Deep Learnings und des Machine Learnings erkunden laufend neue Anwendungsgebiete für Transformer. Einer der vielversprechendsten Fortschritte ist ihre Fähigkeit zur Generierung von Text, die weit über einfache Antworten hinausgeht. Sie können in der Lage sein, komplexe Texte zu verfassen und auf Basis ihres umfangreichen Vokabulars auch kreative Inhalte zu erschaffen.

- Datenverarbeitung: Die Effizienz bei der Verarbeitung großer Datenmengen wird durch die fortlaufende Verbesserung der Transformer-Architekturen gesteigert.

- Anpassungsfähigkeit: Durch Transfer Learning können Transformer für eine Vielzahl spezifischer Aufgaben trainiert werden, ohne dass das Rad jedes Mal neu erfunden werden muss.

Die Rolle von Transformer-Modellen in der Schaffung einer KI, die versteht und generiert

Transformer revolutionieren das Feld des Natural Language Understandings. Sie ermöglichen es KI-Systemen nicht nur, die menschliche Sprache zu verstehen, sondern auch kontextbezogene und sinnvolle Antworten zu generieren.

- Verständnis: Transformer-Modelle analysieren komplexe Sprachmuster und unterstützen die Entwicklung einer KI, die nuancierte menschliche Kommunikation erfassen kann.

- Generierung: Die Fähigkeit, neue Inhalte zu erzeugen, die kohärent und kontextuell relevant sind, zeigt das enorme Potenzial von Transformer-Modellen für die Zukunft der KI.

Diese technologischen Fortschritte bedeuten, dass Ihre Interaktionen mit KI-Systemen natürlicher und intuitiver werden, und damit öffnen sich Türen für innovative Anwendungen in vielen Bereichen unseres Lebens.

sich Türen für innovative Anwendungen in vielen Bereichen unseres Lebens.