Transfer Learning ist eine fortschrittliche Methode des maschinellen Lernens, die in verschiedenen Bereichen der künstlichen Intelligenz, insbesondere im Deep Learning, an Bedeutung gewinnt. Im Kern ermöglicht es Transfer Learning, Wissen, das ein Modell aus einer Aufgabe gewonnen hat, auf eine neue, aber verwandte Aufgabe anzuwenden. Diese Technik ist äußerst nützlich, da sie es erlaubt, auf bereits vortrainierte Modelle zurückzugreifen und diese für unterschiedliche Probleme ohne vollständige Neuprogrammierung zu optimieren.

Beim Einsatz in der Praxis bietet Transfer Learning zahlreiche Vorteile, wie die Beschleunigung des Lernprozesses, da nicht mehr von Grund auf neu gelernt werden muss. Die Verwendung eines vorgefertigten, auf umfangreichen Daten trainierten neuronalen Netzwerks als Ausgangspunkt für spezifische Herausforderungen kann die Entwicklungszeit und Ressourcen erheblich reduzieren. Darüber hinaus kann es dazu beitragen, die Leistungsfähigkeit Ihrer Modelle zu verbessern, insbesondere wenn Sie nur über begrenzte Daten für das Training verfügen. Vor dem Einsatz von Transfer Learning solltest du jedoch die Relevanz des vortrainierten Modells für deine spezifische Aufgabenstellung sorgfältig prüfen.

Kernaussagen

- Transfer Learning nutzt vorhandenes Wissen aus vortrainierten Modellen, um neue Aufgaben effizienter zu lösen.

- Es verkürzt die Entwicklungszeit und verbessert die Leistung deiner Modelle, besonders bei einer geringen Datenverfügbarkeit.

- Die Auswahl eines relevanten vortrainierten Modells ist entscheidend für den Erfolg

Was ist Transfer Learning und warum ist es wichtig?

Die KI-Methode revolutioniert, wie Sie Maschinelles Lernen (ML) nutzen, indem es ermöglicht, bereits gewonnenes Wissen auf neue Probleme anzuwenden.

Transfer Learning: Eine Definition

Unter Transfer Learning versteht man ein Verfahren im Bereich des maschinellen Lernens, bei dem ein vortrainiertes Modell – das bereits auf einer bestimmten Aufgabe trainiert wurde – dazu verwendet wird, die Leistung bei einer neuen, aber ähnlichen Aufgabe zu verbessern. Neuronale Netzwerke und insbesondere Deep Learning-Modelle profitieren enorm von dieser Technik, denn sie können durch Transfer Learning Wissen von einer Domäne auf eine andere übertragen, was als Domänenadaption bezeichnet wird.

Die Schlüsselrolle des Transfer Learnings in der modernen KI

Die Fähigkeit zum Transfer von Wissen ist ein wesentlicher Faktor für den Erfolg von KI-Systemen. Indem bestehende Modelle wiederverwendet werden, sparen Sie nicht nur Ressourcen und Zeit, sondern steigern auch die Performance. Die KI Methode ermöglicht es, komplexe Probleme mit Hilfe von Multi-Task Learning effizienter zu bewältigen und die Generalisierungsfähigkeit der Modelle zu verbessern, was gerade bei der Verarbeitung von unstrukturierten Daten, wie Bildern und Texten, essentiell ist.

Wie Transfer Learning das Machine Learning verändert

Transfer Learning hat das Feld des maschinellen Lernens grundlegend verändert. Es ermöglich Ihnen, durch induktiven Transfer von vortrainierten Modellen, erheblich komplexere Aufgaben zu lösen als je zuvor. Die Nutzung von Deep Learning-Modellen in unterschiedlichen Bereichen von der Bildverarbeitung bis zur Spracherkennung wird durch die Anwendung von Transfer Learning erheblich vereinfacht. Diese Technik verhilft insbesondere dort zu Durchbrüchen, wo der Aufbau und die Pflege einer umfangreichen Datenbank für das Training von Grund auf unpraktikabel wäre.

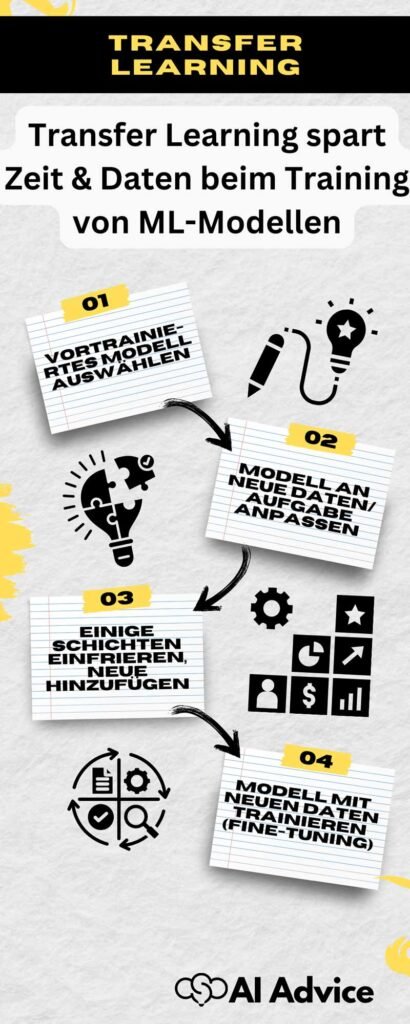

Die Funktionsweise von Transfer Learning

Transfer Learning optimiert den Prozess des maschinellen Lernens, indem vorhandene Modellkenntnisse auf neue, ähnliche Aufgaben übertragen werden. Diese Methodik spart Zeit und Ressourcen und erhöht die Leistungsfähigkeit Ihrer Modelle.

Grundlagen des Modelltrainings in Transfer Learning

Beim Transfer Learning verwenden Sie ein vortrainiertes Modell als Ausgangspunkt. Dieses Modell wurde bereits mit einer großen Menge an Trainingsdaten auf eine spezifische Aufgabe trainiert, etwa Bildklassifizierung auf ImageNet. Anstatt die Gewichte des Netzwerks von Grund auf neu zu lernen, nutzen Sie diese vortrainierten Gewichte und passen sie durch weiterführendes Training (Fine-Tuning) auf Ihre spezifischen Aufgaben an. Dieses Vorgehen ist besonders effektiv, wenn Sie eine begrenzte Menge an Trainingsdaten zur Verfügung haben.

Übertragung von Wissen: Vom vortrainierten Modell zum neuen Einsatz

Für das Transfer Learning wählen Sie gezielt Schichten eines vortrainierten Modells aus, die generische Merkmale (Features) erkennen. Diese Merkmale sind oft universell einsetzbar, wie die Erkennung von Kanten in Bildern. Beim Fine-Tuning passen Sie die letzten Schichten des Modells an Ihre spezielle Aufgabe an. Dabei tauschen Sie häufig die letzte Schicht (Final Layer) aus oder fügen weitere Schichten hinzu, um spezifische Features Ihrer Daten besser zu lernen.

Einsatz von neuronalen Netzen im Transfer Learning

Im Bereich von Deep Learning sind neuronale Netze, insbesondere Convolutional Neural Networks (CNNs), weit verbreitet. CNNs sind effektiv in der Merkmalsextraktion (Feature Extraction) und haben nachgewiesene Erfolge bei visuellen Aufgaben. Das Prinzip wird bei CNNs angewandt, indem Schichten aus einem umfassend trainierten Netz (z.B. auf ImageNet) wiederverwendet und angepasst werden, um die Leistung bei einem neuen Datensatz zu verbessern – ein Prozess, der als Domain Adaptation bezeichnet wird.

Anwendungsfälle von Transfer Learning in der Praxis

Transfer Learning revolutioniert, wie Sie Daten modellieren und vorhersagen. Diese Technik ermöglicht es Ihren Modellen, auf umfangreiches, zuvor erlerntes Wissen zurückzugreifen, was Zeit spart und die Effizienz steigert.

Transfer Learning in der Bildklassifizierung

Mit Transfer Learning in der Bildklassifizierung nutzen Sie vorab trainierte neuronale Netze, um neue Bilder mit wenig Aufwand zu kategorisieren. Beispielsweise verwenden Modelle, die auf ImageNet datenbasiert sind, bereits erlernte Feature Extraktionen um die Effektivität der Bilderkennung zu maximieren. Das spart Ihnen die zeitraubende Sammlung und Labelung großer Mengen an Bilddaten im Bereich des Computer Vision.

Natural Language Processing (NLP) durch Transfer Learning

Im Bereich NLP erlaubt Transfer Learning die Verwendung von vorab trainierten Word Embeddings wie GloVe oder BERT, die sie transferieren können. Diese Modelle erkennen Zusammenhänge zwischen Wörtern und Phrasen und verbessern darauf aufbauend komplexere Aufgaben wie Sentiment Analysis oder Textklassifizierung. Ohne dies wäre das Erlernen dieser Zusammenhänge für jeden neuen Anwendungsfall enorm zeit- und ressourcenintensiv.

Objekterkennung und Gesichtserkennung mit Transfer Learning Techniken

Transfer Learning Verfahren sind essentiell, wenn es um Objekterkennung und Gesichtserkennung geht. Durch die Verwendung eines vortrainierten Classifiers können Sie neue Objekte mit bereits bekannten Merkmalen verknüpfen. Die Effizienz zeigt sich darin, dass Sie nicht jedes Mal ein neuronales Netzwerk von Grund auf neu trainieren müssen, sondern das bestehende, angelernte Wissen nutzen.

Indem Sie Transfer Learning in diese drei Schlüsselbereiche integrieren, optimieren Sie die Leistungsfähigkeit Ihrer Modelle und können neuartige Daten mit weniger Aufwand und mehr Genauigkeit verarbeiten.

Wie wählt man das richtige vortrainierte Modell für Transfer Learning?

Beim Transfer Learning ist die Auswahl des richtigen vortrainierten Modells entscheidend. Das Modell sollte effizient sein, zur Datenmenge passen und leicht an neue Aufgaben angepasst werden können.

Vergleich: Inception vs. ResNet für spezifische Anwendungsfälle

Google Inception Model: Für komplexe Bilderkennungsaufgaben mit einer Vielzahl von Klassen ist das Inception-Modell prädestiniert. Dank seiner tiefen und breiten Architektur kann es Muster auf verschiedenen Ebenen erkennen und abstrahieren.

Microsoft ResNet Model: Wenn Sie tiefere Architekturen benötigen und eine Performance-Steigerung erzielen möchten, ohne von zu vielen Parametern überwältigt zu werden, ist ResNet eine gute Wahl. Die Residual Learning Technik ermöglicht es ResNet, selbst mit hunderten von Layern präzise zu arbeiten und gleichzeitig das Problem des verschwindenden Gradienten zu vermeiden.

Die Bedeutung von Datenmengen und Parametern bei der Auswahl

- Datenmenge: Ihr vortrainiertes Modell sollte zur Größe und Vielfalt Ihrer Datensätze passen. Große Modelle benötigen mehr Daten, um Überanpassung zu vermeiden. Bei kleineren Datenmengen kann Data Augmentation helfen, das Modell zu generalisieren.

- Parameter: Die Anzahl der Parameter beeinflusst die Komplexität und Lernfähigkeit eines Modells. Achten Sie darauf, ein Modell mit der richtigen Balance aus Komplexität und Lernkapazität zu wählen, um sowohl Effizienz als auch eine hohe Leistung zu erzielen.

Anpassung des vortrainierten Modells an neue Aufgaben

Für eine effektive Anpassung an neue Aufgaben ist das Fine-Tuning des Modells entscheidend. Hierbei werden die Hyperparameter des Modells justiert und eventuell einige Schichten für spezifische Tasks neu trainiert.

Bei Multi-Task Learning teilen die Aufgaben oft gemeinsame Merkmale, was die Effizienz des Lernprozesses steigert. Es ist wichtig, die richtige Sample Selection zu treffen, um dem Modell zu ermöglichen, aus den relevantesten Beispielen zu lernen.

Die Herausforderungen und Grenzen beim Einsatz von Transfer Learning

In der Praxis stehen Sie vor spezifischen Herausforderungen, die die Leistungsfähigkeit der Modelle beeinflussen und technische Kenntnisse erfordern. Die Weiterentwicklung dieser Technik hängt von der Bewältigung dieser Grenzen ab.

Begrenzungen durch Daten und Verwandtheit der Aufgaben

Transfer Learning basiert auf der Annahme, dass Wissen von einer Domäne auf eine andere übertragbar ist. Allerdings besteht die Gefahr des negativen Transfers, wenn die Aufgaben nicht ausreichend verwandt sind oder die Datensätze unzureichend sind. Die Domänenanpassung ist entscheidend, um die Relevanz der aus vorhandenen Modellen übertragenen Information für neue Aufgaben zu gewährleisten. Beim Umgang mit ungelabelten Daten kann unsupervised Transfer Learning große Vorteile bieten, erfordert jedoch eine sorgfältige Abstimmung der Modelle.

Überwindung technischer Hürden in Transfer Learning Projekten

Für eine erfolgreiche Implementierung von Projekten sind spezielle Software und Tutorials erforderlich. Die technischen Hürden umfassen die Integration von Expert Knowledge und anspruchsvolle Data Mining Prozesse. Techniken wie zero-shot learning und transductive transfer learning stellen zusätzliche Herausforderungen dar, da sie fortgeschrittene Konzepte und Algorithmen voraussetzen, die über traditionelles maschinelles Lernenhinausgehen.

Die Zukunft: Wie kann Transfer Learning weiterentwickelt werden?

Die Zukunft liegt in der Entwicklung von Methoden, die mit wenig oder gar keine direkte Überwachung oder menschliches Eingreifen auskommen, wie z.B. selbstlernendes Lernen (self-taught learning). Eine Weiterentwicklung könnte breiteren Anwendungen zugänglich machen und Modellleistung in Szenarien steigern, wo bisher Datenbeschränkungen limitierend wirkten.

Praktische Tipps für den Einstieg in Transfer Learning

Transfer Learning ermöglicht es Ihnen, vortrainierte Modelle effizient zu nutzen, um Zeit und Ressourcen zu sparen. Diese Modelle, die bereits auf umfangreichen Datensätzen trainiert wurden, können als Ausgangspunkt für Ihre spezifischen Problemstellungen dienen. Im Folgenden finden Sie praktische Ratschläge, um in diesem Bereich erfolgreich zu starten.

Ressourcen und Werkzeuge für den Einstieg in Transfer Learning

Der erste Schritt ist die Sammlung der richtigen Ressourcen. Online-Tutorials und Dokumentationen sind unerlässlich für das Erlernen der Konzepte. Starten Sie mit Tutorials von Keras oder TensorFlow, da diese Frameworks eine breite Palette von vortrainierten Modellen bieten. In der folgenden Liste finden Sie einige empfehlenswerte Anlaufstellen:

- Keras Dokumentation: https://keras.io/

- TensorFlow Tutorials: https://www.tensorflow.org/tutorials

- PyTorch Guide: https://pytorch.org/tutorials/beginner/transfer_learning_tutorial.html

Best Practices beim Trainieren mit vortrainierten Modellen

Wenn Sie mit vortrainierten Modellen arbeiten, sollten Sie einige Best Practices befolgen, um die besten Ergebnisse zu erzielen:

- Datenvorverarbeitung: Passen Sie Ihre Daten an die Anforderungen des vortrainierten Modells an. Häufig erfordern diese Modelle spezifische Eingabeformate.

- Fine-Tuning: Passen Sie nur die letzten Schichten des Netzes an Ihr spezielles Problem an. Dies verhindert Überanpassung und spart Trainingszeit.

- Lernrate: Beginnen Sie mit einer niedrigen Lernrate, da das Modell bereits vortrainiert ist und nur subtile Anpassungen benötigt.

PyTorch und Transfer Learning: Eine Anleitung für Anfänger

PyTorch ist ein weiteres beliebtes Framework für Deep Learning und Transfer Learning. Um zu starten:

- Installieren Sie PyTorch gemäß den Anweisungen auf https://pytorch.org/get-started/locally/.

- Verwenden Sie Tutorials, um sich mit PyTorch und dessen Modulen vertraut zu machen. PyTorch bietet eine intuitive Syntax, die für Anfänger zugänglich ist.

- Experimentieren Sie mit den vortrainierten Modellen, die in der

torchvision.modelsBibliothek verfügbar sind. Beginnen Sie mit Modellen wie ResNet oder VGG, die häufig für Transfer Learning eingesetzt werden.