Reinforcement Learning (auch verstärkendes Lernen) ist eine fortschrittliche Methode des maschinellen Lernens. Es beruht auf dem Prinzip von Versuch und Irrtum.

In einem sogenannten simulierten Umfeld trifft ein intelligenter Agent Entscheidungen. Er macht das, indem er Aktionen ausführt, für die er Feedback in Form von Belohnungen oder Strafen erhält.

Ziel des Agenten ist es, eine Strategie – auch Policy genannt – zu entwickeln. Diese Strategie soll den kumulativen Gewinn, also die gesammelten Belohnungen, maximieren.

Im Gegensatz zu überwachtem Lernen, bei dem ein Algorithmus anhand von Beispieldaten und klar definierten Antworten trainiert wird, entdeckt der Agent beim Reinforcement Learning selbstständig, welche Aktionen in welchen Zuständen des Umfelds zum Erfolg führen.

Dafür nutzt der Agent die Rückmeldungen aus der Umgebung, um seine Policy kontinuierlich anzupassen und zu verbessern.

Diese Methode findet in dynamischen Umgebungen Anwendung, wo vordefinierte Antworten nicht verfügbar oder praktikabel sind, wie bei Spielen, autonomen Fahrzeugen oder robotergesteuerten Systemen.

Kernaussagen

- Reinforcement Learning ermöglicht es Agenten, durch Interaktion mit der Umgebung optimales Verhalten zu erlernen.

- Der Agent optimiert seine Entscheidungen auf Basis von Belohnungen, um langfristige Ziele zu erreichen.

- Reinforcement Learning unterscheidet sich von anderen Lernmethoden durch seine Fähigkeit, in komplexen, dynamischen Umgebungen zu lernen.

Wie funktioniert Reinforcement Learning und was ist es?

Reinforcement Learning (RL) ist ein Bereich des maschinellen Lernens, bei dem ein Agent durch Interaktion mit seiner Umgebung lernt, optimale Handlungen auszuführen, um seine Ziele zu erreichen. Es handelt sich um einen Lernprozess, bei dem Sie Erfahrungen sammeln und Strategien entwickeln.

Grundprinzipien von Reinforcement Learning

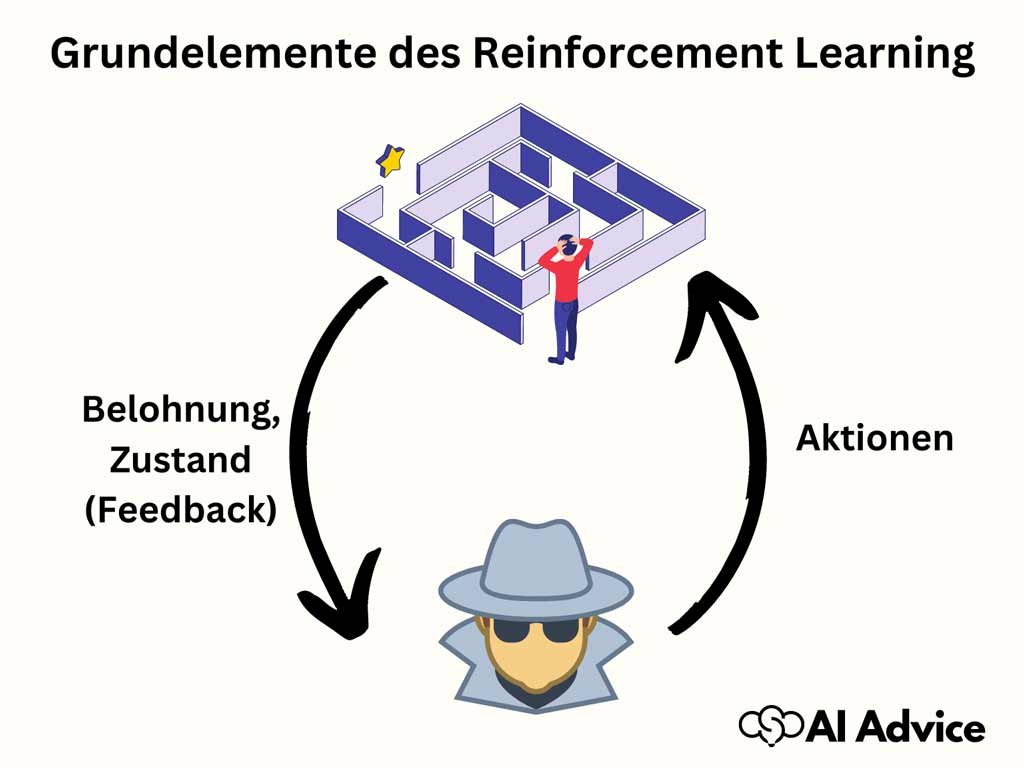

Das Kernelement von Reinforcement Learning ist der Agent, der in einer bestimmten Umgebung agiert und dabei laufend Zustände wahrnimmt und auf diese mit Aktionen reagiert.

Jede Aktion führt zu einer Belohnung (oder Bestrafung), welche als Feedback für das Verhalten des Agenten dient.

Die Aufgabe des Agenten besteht darin, seine Handlungen so anzupassen, dass die kumulative Belohnung über die Zeit maximiert wird. Das Policy bezeichnet dabei die Strategie des Agenten, also wie er in bestimmten Zuständen handelt, um die Belohnung zu maximieren.

Der Unterschied zwischen Reinforcement Learning und traditionellem Machine Learning

Im Gegensatz zum überwachten Lernen (∼supervised learning), wo Modelle mit einem gelabelten Datensatz trainiert werden, und zum unüberwachten Lernen (∼unsupervised learning), das Muster in Daten ohne Label identifiziert, lernt der Agent im RL selbstständig durch das Ausprobieren verschiedener Aktionen und die daraus resultierenden Belohnungen.

Reinforcement Learning ist somit wesentlich interaktiver und zielorientierter. Es gibt modellfreie (∼model-free) Ansätze, bei denen der Agent ohne Kenntnis der Umgebungsdynamik lernt, und modellbasierte (∼model-based) Ansätze, die explizit eine Modellierung der Umgebung vornehmen.

Die Rolle der Belohnung im Lernprozess

Der Lernvorgang im RL wird hauptsächlich durch die Belohnung (∼reward) angetrieben. Diese dient als Signal für den Agenten, welche Aktionen in welchem Zustand vorteilhaft sind.

Die Bewertungsfunktion (∼value function) gibt den erwarteten Gesamtnutzen (cumulative reward) an, den ein Agent in einem bestimmten Zustand erhalten kann, wenn er einer bestimmten Policy folgt.

Die Belohnungsfunktion (∼reward function) definiert, welche sofortige Belohnung (∼immediate reward) der Agent für die Ausführung einer Aktion in einem bestimmten Zustand erhält.

Das Ziel ist, eine Policy zu finden, die den langfristigen Nutzen, die Summe der erhaltenen Belohnungen, maximiert.

Die wichtigsten Algorithmen im verstärkenden Lernen

Im Bereich des Reinforcement Learnings (RL) sind bestimmte Algorithmen besonders relevant. Sie sind die Grundlage dafür, dass ein Agent lernen kann, optimale Handlungen in einer Umgebung auszuführen, basierend auf dem Prinzip der Maximierung der kumulativen Belohnung.

Q-Learning: Ein fundamentaler Algorithmus

Q-Learning ist einer der grundlegenden Algorithmen im Bereich des RL. Er verwendet eine Q-Funktion, um den erwarteten Nutzen einer gegebenen Handlung in einem bestimmten Zustand zu bewerten.

Die Q-Funktion wird iterativ mittels der Bellman-Gleichung aktualisiert, um die Politik zu verbessern.

Ein Hauptmerkmal des Q-Learning ist das Konzept des state-action pairs. Damit schätzt der Algorithmus für jeden Zustand-Aktions-Paar einen Wert ab, der den gesamten zukünftigen Reward reflektiert.

Deep Reinforcement Learning: Kombination von Deep Learning und RL

Deep Reinforcement Learning verknüpft tiefe neuronale Netze, ein Kernkonzept des Deep Learnings, mit RL-Verfahren.

Es erweitert somit Q-learning und andere RL-Techniken, indem es ermöglicht, auch in hochdimensionalen Zustandsräumen, in denen übliche Algorithmen scheitern würden, effektiv zu arbeiten.

Durch die Anwendung von neuronalen Netzwerken ist es dem Deep RL möglich, komplexe Probleme durch Abstraktion und Mustererkennung zu lösen.

Policy-Optimierung und deren Bedeutung

Bei der Policy-Optimierung handelt es sich um einen anderen Ansatz im Reinforcement Learning, bei dem der Fokus auf der direkten Optimierung der Politik liegt, also der Strategie, nach der der Agent handelt.

Policy gradient Methoden, wie der Actor-Critic Ansatz, aktualisieren die Parameter der Politik direkt in Richtung des Gradients, der zu einer höheren Belohnung führt.

Der deterministic policy gradient ist eine Variation, die in kontinuierlichen Aktionsräumen besonders effektiv ist.

Vorteile von Reinforcement Learning gegenüber anderen Lernmethoden

Reinforcement Learning (RL) hebt sich durch seine robuste Anpassungsfähigkeit und selbstständige Problemlösungskompetenz von anderen Lernmethoden ab. Sie profitieren von einem System, das sich fortlaufend durch Feedback aus seiner Umgebung verbessert.

Flexible Anpassung an dynamische Umgebungen

Sie beobachten in RL-Systemen eine hohe Flexibilität, da diese modellfreie oder modellbasierte Ansätze nutzen können, um sich an dynamische Umgebungen anzupassen.

In einem ständigen Trial-and-Error-Prozess lernt der Agent, sich auf Veränderungen effektiv einzustellen und die Strategie laufend zu optimieren.

Die Fähigkeit, komplexe Probleme zu lösen

Besonders bei komplexen Problemen, die schwierig zu modellieren sind, zeigt RL seine Stärken. Es findet Lösungen, indem es durch Exploration neue Strategien ausprobiert und durch Exploitation erfolgreiche Handlungen verstärkt, wobei der Fokus immer auf der Maximierung der Belohnung liegt.

Von Menschen unabhängiges Lernen durch Exploration und Exploitation

Das RL ist darauf ausgelegt, durch eigene Erfahrungen zu lernen und bedarf keiner umfangreichen Datensätze zum Training.

Sie profitieren von einem Agenten, der selbstständig zwischen Exploration (das Erkunden neuer, unbekannter Strategien) und Exploitation (das Ausnutzen bekannter, erfolgreicher Strategien) abwägt, um eine optimale Kontrolle zu erreichen.

Anwendungsbeispiele: Wo Reinforcement Learning bereits eingesetzt wird

In diesem Abschnitt finden Sie konkrete Beispiele dafür, wie Reinforcement Learning (RL) in verschiedenen Bereichen Anwendung findet und die Technologie vorantreibt.

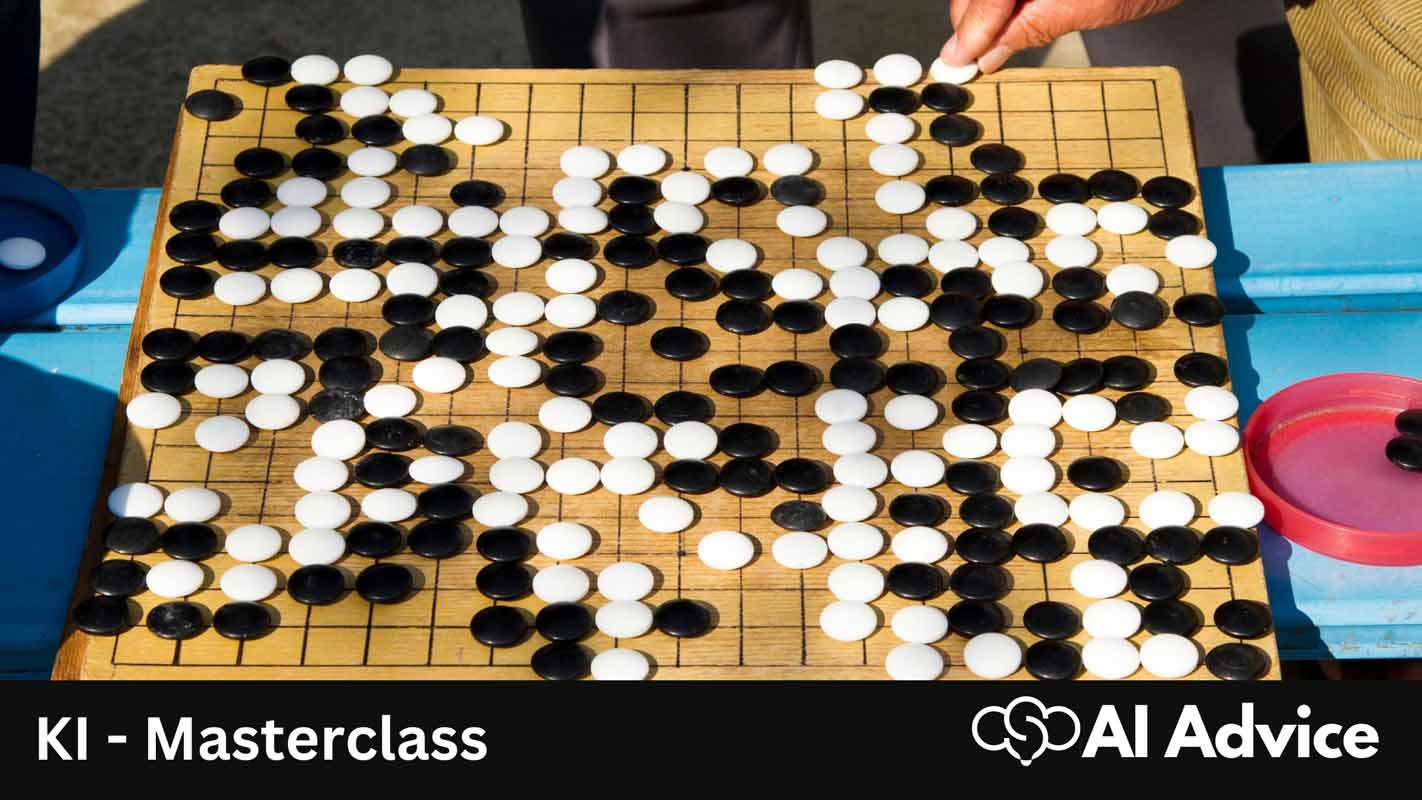

Verbesserung der KI in Spielen wie AlphaGo

Reinforcement Learning hat in der Welt der Spiele zu bedeutenden Durchbrüchen geführt, insbesondere bei AlphaGo.

Dieses Programm verwendet RL in Kombination mit Methoden wie dem Monte Carlo Tree Search, um menschliche Spieler im komplexen Brettspiel Go zu übertreffen.

Die KI von AlphaGo lernt durch die Analyse von Spielen und passt ihre Strategien an, um ihre Gewinnchancen zu maximieren.

Autonome Fahrzeuge: Einsatz von RL für die Navigation

Im Bereich des autonomen Fahrens spielt RL eine entscheidende Rolle für die Entwicklung von Selbstfahrenden Autos.

Durch den Einsatz von RL-Algorithmen können Fahrzeugsysteme optimierte Entscheidungen bei der Navigation treffen, Verkehrssituationen auswerten und lernen, sicherer und effizienter zu fahren.

Reinforcement Learning in der Robotik

In der Robotik ermöglicht RL Robotern, sich Aufgaben durch Interaktion mit ihrer Umgebung anzueignen.

Lernende Roboter verbessern ihre Fähigkeiten und Effizienz kontinuierlich, was in industriellen Anwendungen und bei komplexen Aufgaben, wie der präzisen Handhabung von Objekten oder der Durchführung von Reparaturen, von großem Nutzen ist.

OpenAI entwickelt CriticGPT unter Einsatz von RL

OpenAI hat angekündigt die Entwicklung von CriticGPT unter dem Einsatz von RL voranzutreiben. Hierbei werden zuvor generierte Antworten aus dem Sprachmodell im Anschluss mit einem speziell dafür trainierten Agenten auf Fehler oder Verbesserungsvorschläge trainiert.

Reinforcement Learning vs. Supervised Learning: Ein Vergleich

In diesem Abschnitt betrachten Sie die wesentlichen Unterschiede zwischen Reinforcement Learning und Supervised Learning und verstehen die jeweiligen Anwendungsgebiete sowie Grenzen.

Definition und Unterschiede der Lernmethoden

Supervised Learning (überwachtes Lernen) ist ein Lernprozess, bei dem Sie ein Modell mit einer vordefinierten und gelabelten Datensätzen trainieren. Die Zielsetzung ist es, aus Eingabedaten auf Ausgabedaten zu schließen. Reinforcement Learning (RL, bestärkendes Lernen) hingegen ist ein maschinelles Lernparadigma, wo ein Agent durch Interaktion mit seiner Umgebung lernt, optimale Handlungen auszuführen, um seine Belohnung zu maximieren. Ein zentraler Unterschied liegt in der Datenaufbereitung und dem Feedbackmechanismus. Beim Supervised Learning muss der Output für ein Input-Beispiel bekannt sein. Im Gegensatz dazu wird im RL das Modell durch eine Belohnungsfunktion und Trial-and-Error-Verfahren ohne vordefinierte Beispiele trainiert.

Wann ist Reinforcement Learning der richtige Ansatz?

Reinforcement Learning eignet sich besonders für Situationen, in denen Sie ein dynamisches Umfeld haben, wie z.B. bei Robotersteuerungen oder Spielen, in denen eine strategische Entscheidungsfindung erforderlich ist. Sie nutzen RL, wenn das System durch Exploration und Exploitation selbst herausfinden soll, welche Aktionen in welchen Zuständen zur besten langfristigen Belohnung führen. Model-Free RL und Model-Based RL sind zwei Arten des RL, wobei erstere keine Annahmen über die Umgebung trifft und letztere die Umgebung modelliert, um Vorhersagen zu treffen.

Limitationen von Supervised Learning und die Überlegenheit von RL in bestimmten Aspekten

Supervised Learning hat seine Limitationen, vor allem wenn kein umfangreicher, annotierter Datensatz verfügbar ist oder das Umfeld sich ständig ändert. Hier kann Reinforcement Learning seine Stärken ausspielen, denn es erfordert keine Label, und der Agent kann in einer sich ständig ändernden Umgebung durch Trial and Error lernen. Darüber hinaus kann RL besser mit Situationen umgehen, in denen langfristige Ziele und nicht sofortige Belohnungen im Vordergrund stehen. Es ist wichtig zu beachten, dass beide Lernmethoden ihre spezifischen Algorithmen und Anwendungsgebiete haben. Eine Methode ist nicht generell einer anderen überlegen, sondern abhängig von der jeweiligen Aufgabenstellung.

Die Zukunft von Reinforcement Learning in der Künstlichen Intelligenz

Reinforcement Learning (RL) ist ein dynamisches Feld, das eine tragende Rolle für Fortschritte in der künstlichen Intelligenz (KI) spielt. Fortschrittliche Algorithmen und Technologien ermöglichen neue Entwicklungsstufen der KI-Systeme. Ihre Zukunft in der Künstlichen Intelligenz ist geprägt von der Entwicklung hin zur Artificial General Intelligence (AGI), der Bewältigung von Herausforderungen im Deep Reinforcement Learning und dem Potenzial, globale Probleme zu adressieren.

Die Rolle von Reinforcement Learning in der Entwicklung der Artificial General Intelligence (AGI)

Reinforcement Learning ist eine Schlüsselkomponente auf dem Weg zur Artificial General Intelligence (AGI). Dabei liegt der Fokus auf der Generalisierung von Wissen und der Anpassungsfähigkeit von KI-Systemen an dynamische Umgebungen. Ihr Ziel ist es, Methoden zu schaffen, die durch Funktionsapproximation und Policy-Gradient-Methoden die kognitive Flexibilität von Menschen emulieren können.

Trends und Herausforderungen im Bereich des Deep Reinforcement Learning

Beim Deep Reinforcement Learning verbinden sich RL mit neuronalen Netzwerken, um komplexe Entscheidungsprozesse zu optimieren. Die Herausforderung besteht darin, noisy data besser zu interpretieren und Algorithmen so zu entwickeln, dass sie schneller und effizienter lernen. Ein weiterer Trend ist die Schaffung erklärbarer AI-Modelle, die transparente Entscheidungswege ermöglichen.

Potenziale von Reinforcement Learning für das Lösen globaler Probleme

RL bietet das Potenzial, Lösungen für weltweite Herausforderungen zu entwickeln. Durch das Lernen aus Interaktionen können Systeme komplexe Zusammenhänge verstehen. Sie können beispielsweise den Klimawandel oder das Ressourcenmanagement analysieren und optimierte Strategien ausarbeiten. Ihre Fähigkeit zur Anpassung an veränderliche Bedingungen macht sie zu einem wertvollen Werkzeug für globale Anwendungen.