Ein Recurrent Neural Network (oder auch Rekurrente neuronale Netze, oder RNNs), sind eine spezialisierte Art von künstlichen neuronalen Netzwerken, die besonders geeignet sind, um mit sequentiellen Daten zu operieren. Ihre Stärke liegt darin, dass sie Information aus vorangegangenen Eingaben speichern und für die Verarbeitung späterer Eingaben nutzen können. Dies ermöglicht es RNNs, Muster zu erkennen, die sich über verschiedene Zeitpunkte erstrecken. Dies ist beispielsweise in der Spracherkennung oder bei der Vorhersage von Zeitreihen von Bedeutung.

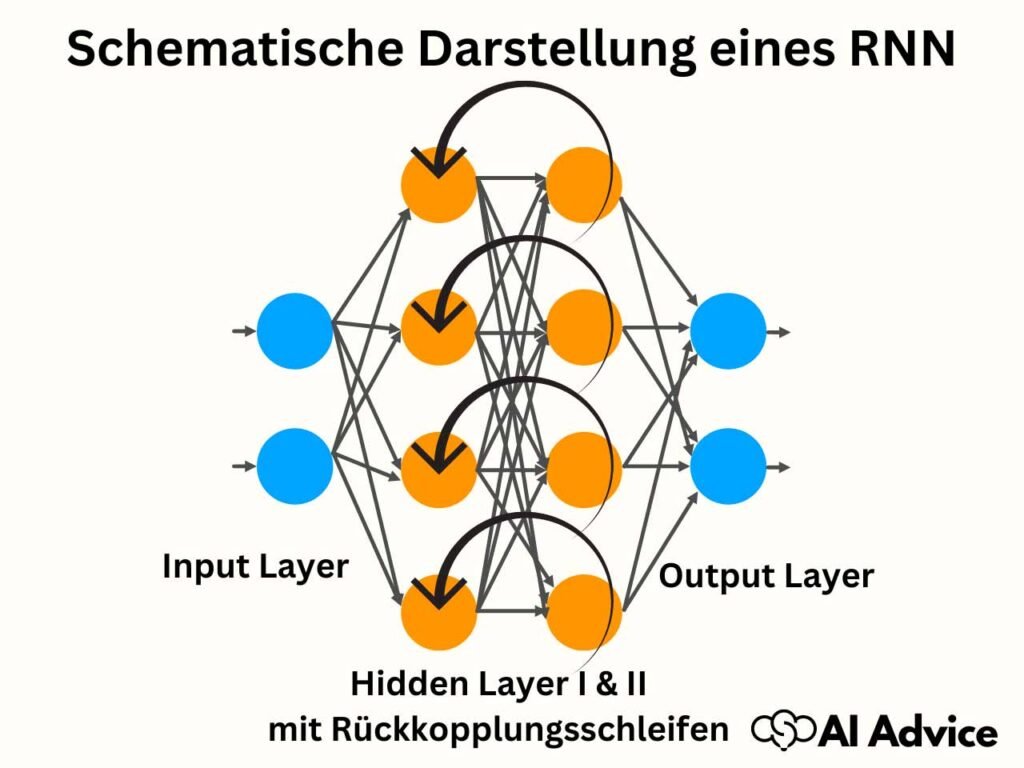

Die Struktur eines Recurrent Neural Network erlaubt es ihm, Rückkopplungsschleifen zu bilden. Anders als bei traditionellen Feedforward-Netzwerken, bei denen Informationen nur in eine Richtung fließen, können RNNs ihre Ausgaben als Eingaben in späteren Schritten wiederverwenden. Dieser Prozess verleiht dem Netzwerk ein Gedächtnis. RNNs sind daher besonders wirksam bei Aufgaben wie der Verarbeitung natürlicher Sprache oder der Generierung von Text. Dort ist der Kontext und die Reihenfolge der Informationen entscheidend.

Kernaussagen

- RNNs sind besonders für Aufgaben mit sequentiellen Daten wie der Sprachverarbeitung geeignet.

- Sie unterscheiden sich von anderen neuronalen Netzwerken durch ihre Fähigkeit, Informationen zu speichern und zu nutzen.

- Die Architektur eines Recurrent Neural Network ermöglicht es, dass Ausgaben zukünftige Eingaben beeinflussen können.

Was ist ein rekurrentes neuronales Netz (RNN)?

Ein rekurrentes neuronales Netz (RNN) ist ein fortgeschrittenes Modell der künstlichen Intelligenz, spezialisiert auf die Verarbeitung von sequentiellen Daten durch die Implementierung von Feedback-Schleifen in seiner Architektur.

Grundlagen der RNNs und ihre Bedeutung in der neuronalen Netzwerktechnologie

RNNs sind eine Untergruppe der neuronalen Netze, die für die Verarbeitung von sequenziellen Daten wie Sprache und Text unabdingbar sind. Im Gegensatz zu anderen Netzwerktypen können RNNs Informationen durch ihre Schleifenstruktur im Kurzzeitgedächtnis behalten. Dies ermöglicht es ihnen, Kontext und Abhängigkeiten in den Daten zu erfassen. RNNs sind ein wesentliches Werkzeug im Bereich des Deep Learning und haben eine Vielzahl von Anwendungen, darunter Spracherkennung und maschinelle Übersetzung.

Der Vergleich zwischen RNNs und traditionellen neuronalen Netzwerken

Traditionelle neuronale Netzwerke, wie Feedforward-Netzwerke (FFNs), verarbeiten Informationen in einer einzigen Richtung von Eingabe zu Ausgabe ohne eine Rückführung. Die Architektur von RNNs hingegen erlaubt es ihnen, durch eine Feedback-Schleife Informationen zwischen Neuronen rückzukoppeln. Dieser Feedback-Mechanismus ist entscheidend für das Modellieren von sequenziellen Abhängigkeiten und damit für die Bereitstellung eines internen Gedächtnisses, das zwischen verbundenen Sequenzen oder Zeitpunkten besteht.

Die einzigartigen Merkmale von rekurrenten neuronalen Netzen

RNNs sind einzigartig durch ihre Fähigkeit, sequenzielle Informationen zu speichern und zu nutzen. Dies geschieht durch rekurrente Verbindungen, die es Signalen ermöglichen, in einem geschlossenen Kreislauf zu zirkulieren. Dadurch erhält das Netzwerk eine Form von Gedächtnis, das Unterscheidungen zwischen kurz- und langfristigen Abhängigkeiten trifft – elementar für komplexe Aufgaben wie das Verstehen von Sprache. Die Architektur eines Recurrent Neural Network schließt daher ein Geflecht aus verbundenen Neuronen ein, welche Eingaben nicht nur von den vorherigen Schichten, sondern auch von sich selbst zu früheren Zeitpunkten erhalten.

Diese Eigenschaften machen RNNs zu einem entscheidenden Algorithmus innerhalb der neuronalen Netzwerktechnologie, insbesondere bei der Verarbeitung und Vorhersage in datenreichen sequenziellen Umgebungen.

Wie funktionieren rekurrente neuronale Netze?

Rekurrente neuronale Netze (RNNs) sind für die Mustererkennung in sequenziellen Daten konzipiert und nutzen die interne Zustandsspeicherung, um auf vorherige Informationen zurückzugreifen.

Verstehen der Rückkopplungen innerhalb rekurrenter Netze

Betrachten Sie RNNs als eine Erweiterung herkömmlicher neuronaler Netze mit einer signifikanten Zusatzfunktion: der Fähigkeit, Informationen über die Zeit hinweg zu speichern. Ihre Struktur umfasst Rückkopplungen, die signalisieren, dass gewisse Neuronen in der Architektur ihre Ausgaben nicht nur an die nächste Schicht senden, sondern auch an sich selbst zu einem späteren Zeitpunkt zurückgeben. Diese Rückkopplungen schaffen einen internen Zustand (oder hidden state), der eine Art Gedächtnis bildet und somit das Netz in die Lage versetzt, sequenzielle Daten wie Zeitreihen effizient zu verarbeiten.

Die Rolle von Long Short-Term Memory (LSTM) und Gated Recurrent Units (GRUs)

Long Short-Term Memory Netzwerke (LSTMs) sind eine spezialisierte Form von RNNs, konzipiert, um die Limitationen normaler RNNs anzugehen, speziell das Problem des sogenannten „längeren Gedächtnisses“. LSTMs haben ein ausgeklügeltes Torsystem bestehend aus dem Forget Gate, Input Gate, Output Gate und Update Gate, das bestimmt, welche Informationen vergessen, aktualisiert oder beibehalten werden sollen. Gated Recurrent Units (GRUs) sind eine ähnliche Variante, die jedoch eine vereinfachte Struktur aufweisen, indem sie die Tore und Zustände in einer Weise kombinieren, die weniger parametrisch ist, aber in vielen Fällen ähnlich effektiv wie LSTMs funktioniert.

Sequenzielles Lernen und Zeitschrittbearbeitung in RNNs

Ein grundlegendes Merkmal von RNNs ist ihre Fähigkeit zum sequenziellen Lernen; das heißt, sie verarbeiten Informationen über Zeitreihen, indem sie Schritt für Schritt vorgehen. Während der Backpropagation wird diese sequenzielle Natur durch eine Methode namens Backpropagation Through Time (BPTT) betont. Hierbei werden die Eingabesequenzen zusammen mit ihrem temporalen Kontext genutzt, um die optimalen Gewichtungen im Netz anzupassen und das Verhalten über Zeitschritte hinweg zu optimieren, was es ideal für Aufgaben wie Spracherkennung oder Vorhersagen in Zeitreihendaten macht.

Anwendungsbereiche von RNNs

Rekurrente neuronale Netze (RNNs) sind ein mächtiges Werkzeug im Bereich des maschinellen Lernens, welches Sie für die Analyse und Vorhersage von sequenziellen Daten einsetzen können. Sie zeichnen sich durch ihre Fähigkeit aus, frühere Informationen zu nutzen, um zukünftige Ereignisse zu beeinflussen oder vorherzusagen.

RNNs in der Verarbeitung natürlicher Sprache (Natural Language Processing, NLP)

RNNs werden häufig in der Verarbeitung natürlicher Sprache eingesetzt, wo es darum geht, Textdaten zu analysieren und zu verstehen. Beispiele für Modelle im NLP-Bereich umfassen die Sentiment-Klassifikation, bei der die emotionale Tendenz eines Texts erkannt wird, und die Sprachübersetzung, die komplexe Zusammenhänge zwischen zwei Sprachen herstellen muss. RNNs sind in der Lage, aus umfangreichen Textdaten zu lernen und sprachliche Muster zu erkennen.

Zeitreihenanalyse und Vorhersagemodelle mit rekurrenten neuronalen Netzen

Bei der Zeitreihenanalyse verwenden Sie rekurrente neuronale Netze, um Vorhersagen über zukünftige Datenpunkte auf Basis historischer Zeitreihendaten zu treffen. In der Wirtschaft, Meteorologie oder im Finanzsektor werden RNNs verwendet, um dynamische Systeme zu modellieren und präzise Prognosemodelle zu erstellen. Diese Modelle helfen Ihnen, Trends oder wiederkehrende Muster in den Daten zu identifizieren und entsprechende Vorhersagen zu machen.

Einsatz von RNNs in der Spracherkennung

In der Spracherkennung spielen RNNs eine wesentliche Rolle, indem sie Audiosequenzen in Text umwandeln. Maschinelles Lernen, insbesondere RNNs, ermöglicht es Computern, Sprache zu erkennen und zu verarbeiten. Dadurch können Sie von Anwendungen profitieren, die von Sprachsteuerungssystemen bis hin zu Echtzeit-Übersetzungsdiensten reichen. RNNs können durch ihre Struktur langfristige Abhängigkeiten in der Sprache effizienter verarbeiten als andere neuronale Netzwerke.

Herausforderungen beim Arbeiten mit RNNs

Beim Einsatz von rekurrenten neuronalen Netzwerken (RNNs) im Deep Learning stehen Sie vor einigen spezifischen Herausforderungen. Diese betreffen die Stabilität und Effizienz des Trainingsprozesses sowie die Qualität der Modellgeneralisierung.

Probleme des verschwindenden Gradienten und Lösungsansätze

Das Problem des verschwindenden Gradienten tritt auf, wenn bei der Backpropagation durch die Zeit (Backpropagation Through Time, BPTT) die Gradienten der Verlustfunktion (Loss Function), die für die Anpassung des Modells verwendet werden, exponentiell schnell kleiner werden. Dies führt dazu, dass die Gewichtsaktualisierungen in den unteren Schichten des Netzwerks verschwindend gering sind, was das Lernen langfristiger Abhängigkeiten erschwert. Ein Ansatz zur Lösung dieses Problems ist die Verwendung von Long Short-Term Memory (LSTM) oder Gated Recurrent Units (GRU), deren Aktivierungsfunktionen das Verschwinden des Gradienten mindern können.

Rekurrente Netze trainieren: Tipps und Techniken

Für das effektive Training von RNNs ist ein ausgewogenes Lernalgorithmus-Design entscheidend. Nutzen Sie Gradient Clipping, um das Gegenstück – explodierende Gradienten – zu vermeiden. Es empfiehlt sich auch, die Initialisierung der Gewichte und die Auswahl geeigneter Aktivierungsfunktionen sorgfältig zu gestalten. Des Weiteren können Regularisierungstechniken wie Dropout angewendet werden, um das Netzwerk während des Trainings robuster zu machen.

Optimierung der Netzwerkperformance und Vermeidung von Überanpassung

Die Optimierung der Performance Ihres RNN-Modells bedeutet, die Fehlerquote zu verringern und gleichzeitig Überanpassung (Overfitting) zu vermeiden. Dazu gehört die Verwendung von Validierungsdaten, um die Generalisierungsfähigkeit Ihres Modells zu überprüfen. Zusätzliche Maßnahmen wie Early Stopping oder die Anpassung der Komplexität des Netzwerks können die Modellleistung verbessern, indem sie sicherstellen, dass das Netzwerk sich nicht zu sehr an die Trainingsdaten anpasst und dabei die Fähigkeit zur Generalisierung auf neue Daten verliert.

Typen von Recurrent Neural Networks

Recurrent Neural Networks (RNNs) sind spezialisierte Architekturen, die für die Verarbeitung sequenzieller Daten, wie natürliche Sprache oder Zeitreihen, entwickelt wurden. Sie sind tief in die Domäne des Deep Learning eingebettet und bieten durch ihre einzigartige Struktur Vorteile im Vergleich zu Feedforward-Netzen.

Ein Überblick über LSTM und GRU: Fortschritte in rekurrenten Netzstrukturen

Long Short-Term Memory (LSTM) und Gated Recurrent Unit (GRU) haben die RNN-Architektur revolutioniert, indem sie das Problem des verschwindenden Gradienten angehen. LSTM-Netze besitzen eine komplexere Struktur mit Gates, die steuern, welche Informationen behalten oder vergessen werden. GRU vereinfacht das LSTM-Modell, indem es weniger Gates verwendet und trotzdem ähnliche Fähigkeiten beibehält.

- LSTM:

- Struktur: Input-Gate, Forget-Gate, Output-Gate

- Vorteil: Präzise Kontrolle über den Informationsfluss

- Anwendung: Spracherkennung, Textgenerierung

- GRU:

- Struktur: Reset-Gate, Update-Gate

- Vorteil: Geringere Komplexität, schnelleres Training

- Anwendung: Maschinelle Übersetzung, Musikgenerierung

Feedforward vs. RNN: Wahl des richtigen Netzwerktyps für Ihr Projekt

Im Kontext sequenzieller Daten sind RNNs Ihren feed-forward Pendants überlegen. Feedforward-Netzwerke, z.B. Convolutional Neural Networks (CNNs), sind für statische Daten wie Bilder ausgelegt. RNN erlaubt hingegen, Informationen aus früheren Eingabesequenzen zu speichern, um den Kontext bei der aktuellen Verarbeitung zu berücksichtigen.

- RNN:

- Vorteil: Berücksichtigung von sequentieller Abhängigkeit

- Einsatzgebiete: Text- und Sprachverarbeitung

- Feedforward:

- Vorteil: Strukturelle Einfachheit, schnelle Vorwärtsberechnungen

- Einsatzgebiete: Bildklassifizierung, Objekterkennung

Convolutional LSTM: Eine Synthese aus CNNs und RNNs für Bilddaten

Convolutional LSTM ist eine innovative Architektur, die die räumliche Hierarchie aus CNNs mit der zeitlichen Sequenzeigenschaft aus LSTMs kombiniert. Diese Kombination eignet sich perfekt für Aufgaben wie Bilduntertitelung oder Videoverarbeitung, wo sowohl räumliche als auch zeitliche Daten gleichzeitig betrachtet werden müssen.

- Convolutional LSTM:

- Besonderheit: Integration von konvolutionalen Schichten in LSTM

- Anwendung: Bildsequenzanalyse, z.B. in Wettervorhersagemodellen

Mit TensorFlow, einer der führenden Plattformen für Deep Learning, können Sie diese verschiedenen RNN-Architekturen ausprobieren und je nach Anforderung des Projekts die geeignete auswählen.

Zukunft und Weiterentwicklung von RNNs

Die fortschreitende Entwicklung von rekurrenten neuronalen Netzen (RNNs) wird durch neue Forschungsansätze und die Integration mit Deep Learning vorangetrieben. Sie können erwarten, dass die nächste Generation von RNNs noch leistungsfähiger und vielseitiger sein wird.

Neue Forschungsansätze in der Welt der rekurrenten neuronalen Netze

Aktuelle Forschungsprojekte im Bereich der RNNs konzentrieren sich darauf, die Rechenleistung zu optimieren und die Algorithmen robuster gegenüber Fehlern zu machen. Forscher suchen nach Wegen, wie RNNs besser mit komplexen, sequenziellen Daten umgehen können. Dies beinhaltet das Trainieren von Modellen mit einer noch nie dagewesenen Datenmenge, was anspruchsvollere und leistungsfähigere Modelle ermöglicht.

Integration von Deep Learning und RNNs

Durch den Einbezug von Deep Learning-Techniken werden RNNs verstärkt in der Lage sein, komplexe Verhaltensmuster zu erkennen und zu lernen. Geräte wie Siri und Services wie Google Translate profitieren von diesen Verbesserungen, indem sie menschliche Sprache präziser verstehen und übersetzen. Dieser Fortschritt könnte bald zu persönlichen Assistenten führen, die in der Lage sind, fließender und genauer als zuvor auf Ihre Anfragen zu reagieren.

Die nächste Generation von RNNs: Was steht bevor?

In Bezug auf die zukünftige Entwicklung wird erwartet, dass RNNs noch innovativere Anwendungen in den Feldern künstliches neuronales Netzwerk und Maschinelles Lernen finden werden. Dies könnte die Entwicklung von Systemen beinhalten, die Verhaltensänderungen über die Zeit erkennen und autonom darauf reagieren können. Die künstliche Intelligenz wird dadurch in ihrer Funktion und Anwendungsbreite noch mächtiger und vielfältiger.