Nvidia NIM bietet eine Lösung für diese Herausforderungen, indem es Unternehmen ermöglicht, ihre KI-Modelle schnell und einfach in Produktion zu bringen. Mit NIM können Unternehmen von den Vorteilen der generativen KI profitieren, ohne sich um die zugrunde liegende Infrastruktur kümmern zu müssen.

Aber was genau ist Nvidia NIM und wie funktioniert es? In diesem Artikel tauchen wir tiefer ein und beantworten alle Ihre Fragen zu dieser neuen KI-Plattform.

Was ist Nvidia NIM?

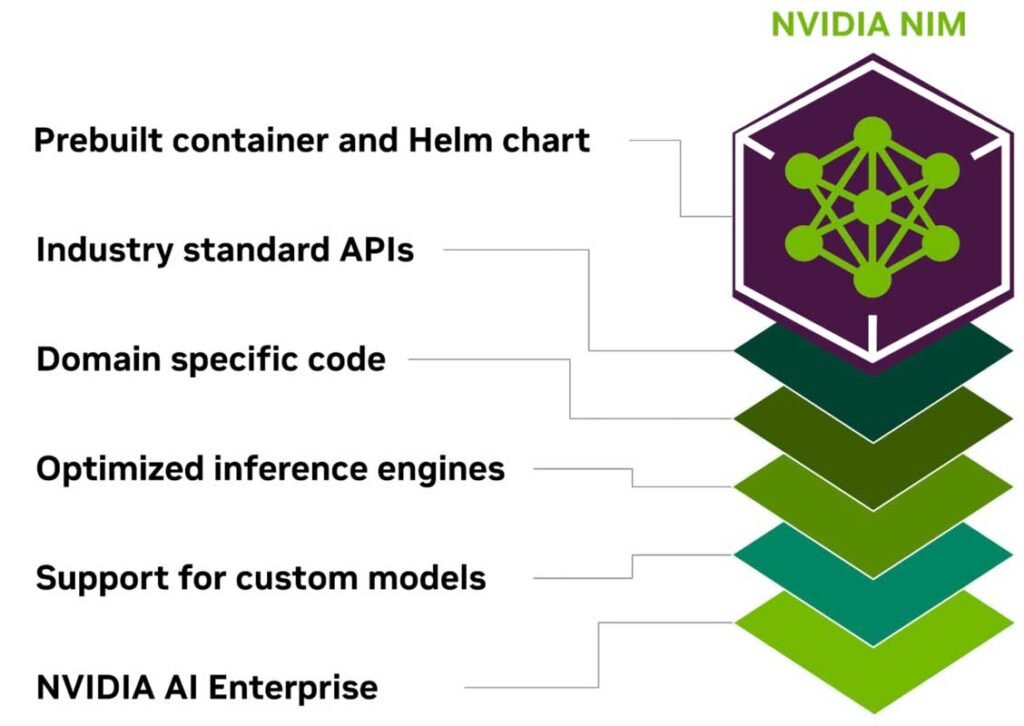

Nvidia NIM steht für „NVIDIA Inference Microservices“ und ist eine Softwareplattform, die speziell für die Bereitstellung von KI-Modellen in Produktionsumgebungen entwickelt wurde. Mit NIM können Unternehmen ihre KI-Modelle schnell und einfach in Container verpacken und in ihre bestehenden Anwendungen integrieren.

Die Plattform bietet vorkonfigurierte Umgebungen und Optimierungen, die speziell auf die Anforderungen von KI zugeschnitten sind. Dadurch können Unternehmen ihre KI-Modelle schneller in Produktion bringen und von den Vorteilen der generativen KI profitieren, ohne sich um die zugrunde liegende Infrastruktur kümmern zu müssen.

Hauptmerkmale und Funktionen von Nvidia NIM

Nvidia NIM bietet eine Reihe von Funktionen, die speziell auf die Anforderungen von KI-Workloads zugeschnitten sind:

- Vorkonfigurierte Container: NIM bietet vorkonfigurierte Container-Images für gängige KI-Frameworks und -Modelle, die sofort einsatzbereit sind.

- Optimierte Laufzeitumgebungen: Die Plattform bietet optimierte Laufzeitumgebungen, die speziell auf die Anforderungen von KI-Workloads zugeschnitten sind, wie z.B. GPU-Beschleunigung und Speicheroptimierung.

- Skalierbarkeit: NIM ist hochgradig skalierbar und kann je nach Bedarf schnell hoch- oder herunterskaliert werden.

- Einfache Integration: Die Plattform kann nahtlos in bestehende Unternehmensanwendungen und -infrastrukturen integriert werden.

- Überwachung und Protokollierung: NIM bietet integrierte Überwachungs- und Protokollierungsfunktionen, mit denen Unternehmen die Leistung ihrer KI-Modelle im Auge behalten können.

Unterstützte Modelle, APIs und Frameworks

Nvidia NIM unterstützt eine Vielzahl von gängigen KI-Frameworks und -Modellen, darunter:

- TensorFlow

- PyTorch

- ONNX

- TensorRT

- Triton Inference Server

Die Plattform bietet auch eine Reihe von APIs und SDKs, mit denen Entwickler ihre KI-Modelle in NIM integrieren und verwalten können. Dazu gehören:

- REST API

- gRPC API

- Python SDK

- C++ SDK

Mit diesen Tools können Entwickler ihre KI-Modelle nahtlos in ihre Anwendungen integrieren und von den Vorteilen von NIM profitieren.

Wie NIM im Vergleich zu anderen Lösungen abschneidet

Es gibt viele verschiedene Ansätze zur Bereitstellung von KI-Modellen in Produktionsumgebungen, von denen jeder seine eigenen Vor- und Nachteile hat. Hier sind einige der wichtigsten Unterschiede zwischen Nvidia NIM und anderen Lösungen:

- Einfachheit: NIM ist speziell darauf ausgelegt, die Bereitstellung von KI-Modellen so einfach wie möglich zu machen. Mit vordefinierten Containern und optimierten Laufzeitumgebungen können Unternehmen ihre Modelle schnell in Produktion bringen, ohne sich um die zugrunde liegende Infrastruktur kümmern zu müssen.

- Leistung: NIM ist für Hochleistungs-KI-Workloads optimiert und nutzt die neuesten Technologien wie GPU-Beschleunigung und Speicheroptimierung. Dadurch können Unternehmen ihre KI-Modelle mit maximaler Geschwindigkeit und Effizienz ausführen.

- Skalierbarkeit: Mit seiner Container-basierten Architektur ist NIM hochgradig skalierbar und kann je nach Bedarf schnell hoch- oder herunterskaliert werden. Dies ermöglicht es Unternehmen, ihre KI-Workloads flexibel an ihre Anforderungen anzupassen.

- Integration: NIM kann nahtlos in bestehende Unternehmensanwendungen und -infrastrukturen integriert werden, was die Einführung von KI in Unternehmen erleichtert.

Nvidia NIM: So vereinfacht die Plattform die Bereitstellung von KI-Modellen

Aber wie genau vereinfacht NIM die Bereitstellung von KI-Modellen und welche Vorteile bietet die Plattform für Unternehmen? Nachfolgend gehen wir näher darauf ein.

Vorkonfigurierte Container und Optimierungen

Eines der Hauptmerkmale von Nvidia NIM sind die vorkonfigurierten Container und optimierten Laufzeitumgebungen. Aber was bedeutet das genau und warum ist es so wichtig für die Bereitstellung von KI-Modellen?

Stellen Sie sich vor, Sie möchten ein neues KI-Modell in Produktion bringen. Normalerweise müssten Sie zunächst die erforderlichen Bibliotheken und Abhängigkeiten installieren, die Laufzeitumgebung konfigurieren und sicherstellen, dass alles reibungslos zusammenarbeitet. Das kann zeitaufwendig und fehleranfällig sein, insbesondere wenn Sie mit komplexen KI-Frameworks und -Modellen arbeiten.

Hier kommt Nvidia NIM ins Spiel. Die Plattform bietet vorkonfigurierte Container-Images für gängige KI-Frameworks und -Modelle, die sofort einsatzbereit sind. Diese Container enthalten alle erforderlichen Bibliotheken, Abhängigkeiten und Konfigurationen, so dass Sie Ihr KI-Modell direkt einsetzen können, ohne sich um die Einrichtung der Umgebung kümmern zu müssen.

Darüber hinaus bietet NIM optimierte Laufzeitumgebungen, die speziell auf die Anforderungen von KI-Workloads zugeschnitten sind. Dazu gehören Funktionen wie GPU-Beschleunigung und Speicheroptimierung, die dafür sorgen, dass Ihre KI-Modelle mit maximaler Geschwindigkeit und Effizienz ausgeführt werden.

Einfache Integration mit bestehenden Unternehmensanwendungen

Ein weiterer Vorteil von Nvidia NIM ist die einfache Integration mit bestehenden Unternehmensanwendungen und -infrastrukturen. Aber warum ist das so wichtig und wie funktioniert es in der Praxis?

Viele Unternehmen haben bereits eine Vielzahl von Anwendungen und Systemen im Einsatz, die für ihre Geschäftsabläufe von entscheidender Bedeutung sind. Die Einführung von KI in diese bestehenden Umgebungen kann eine Herausforderung darstellen, insbesondere wenn es darum geht, die KI-Modelle nahtlos in die vorhandenen Workflows zu integrieren.

Nvidia NIM löst dieses Problem, indem es eine Reihe von APIs und SDKs bereitstellt, mit denen Entwickler ihre KI-Modelle nahtlos in ihre Anwendungen integrieren können. Egal, ob Sie eine Web-Anwendung, eine mobile App oder ein Backend-System haben, NIM bietet die Tools, die Sie benötigen, um Ihre KI-Modelle schnell und einfach einzubinden.

Ein Beispiel dafür, wie dies in der Praxis funktionieren kann, ist ein Einzelhändler, der generative KI nutzen möchte, um personalisierte Produktempfehlungen für seine Kunden zu erstellen. Mit Nvidia NIM kann der Einzelhändler sein KI-Modell in einen Container packen und über die API in seine E-Commerce-Plattform integrieren. Sobald das Modell eingebunden ist, kann es nahtlos mit den bestehenden Kundendaten und -profilen arbeiten, um maßgeschneiderte Empfehlungen zu generieren und das Einkaufserlebnis zu verbessern.

Skalierbarkeit und Leistung

Ein weiterer wichtiger Aspekt bei der Bereitstellung von KI-Modellen in Produktionsumgebungen ist die Skalierbarkeit und Leistung. Wenn immer mehr Benutzer auf Ihre KI-Anwendungen zugreifen, müssen Sie sicherstellen, dass Ihre Modelle mit der Nachfrage Schritt halten können, ohne an Geschwindigkeit oder Zuverlässigkeit einzubüßen.

Nvidia NIM bewältigt diese Herausforderung mit Leichtigkeit. Die Container-basierte Architektur der Plattform ermöglicht es, KI-Workloads je nach Bedarf schnell hoch- oder herunterzuskalieren. Wenn die Nachfrage steigt, können Sie einfach zusätzliche Container hinzufügen, um die Last zu verteilen. Wenn die Nachfrage sinkt, können Sie Container entfernen, um Ressourcen freizugeben und Kosten zu sparen.

Darüber hinaus ist NIM für Hochleistungs-KI-Workloads optimiert und nutzt die neuesten Technologien wie GPU-Beschleunigung und Speicheroptimierung. Dadurch können Sie Ihre KI-Modelle mit maximaler Geschwindigkeit und Effizienz ausführen, selbst wenn viele Benutzer gleichzeitig darauf zugreifen.

Nvidia NIM vs. andere Lösungen: Ein Vergleich

Wie schneidet Nvidia NIM im Vergleich zu anderen Lösungen ab? Welche Vor- und Nachteile hat die Plattform und für welche Anwendungsfälle ist sie am besten geeignet? Lassen Sie uns nun einen genaueren Blick auf diese Fragen werfen.

Vor- und Nachteile von NIM im Vergleich zu anderen Lösungen

Es gibt verschiedene Ansätze und Plattformen für die Bereitstellung von KI-Modellen in Produktionsumgebungen, jede mit ihren eigenen Stärken und Schwächen. Hier sind einige der wichtigsten Vor- und Nachteile von Nvidia NIM im Vergleich zu anderen Lösungen:

Vorteile von Nvidia NIM

- Einfachheit: NIM ist speziell darauf ausgelegt, die Bereitstellung von KI-Modellen so einfach wie möglich zu machen. Mit vordefinierten Containern und optimierten Laufzeitumgebungen können Unternehmen ihre Modelle schnell in Produktion bringen.

- Leistung: NIM ist für Hochleistungs-KI-Workloads optimiert und nutzt die neuesten Technologien wie GPU-Beschleunigung und Speicheroptimierung. Dadurch können Unternehmen ihre KI-Modelle mit maximaler Geschwindigkeit und Effizienz ausführen.

- Skalierbarkeit: Mit seiner Container-basierten Architektur ist NIM hochgradig skalierbar und kann je nach Bedarf schnell hoch- oder herunterskaliert werden. Dies ermöglicht es Unternehmen, ihre KI-Workloads flexibel an ihre Anforderungen anzupassen.

- Integration: NIM kann nahtlos in bestehende Unternehmensanwendungen und -infrastrukturen integriert werden, was die Einführung von KI in Unternehmen erleichtert.

Nachteile von Nvidia NIM

- Komplexität: Obwohl NIM darauf abzielt, die Bereitstellung von KI-Modellen zu vereinfachen, kann die Plattform für Einsteiger immer noch komplex sein. Unternehmen benötigen möglicherweise spezielles Fachwissen, um NIM effektiv zu nutzen.

- Kosten: Die Nutzung von Nvidia NIM kann mit zusätzlichen Kosten verbunden sein, insbesondere wenn Unternehmen leistungsstarke GPU-Ressourcen benötigen. Dies kann für kleinere Unternehmen oder Projekte mit begrenztem Budget eine Herausforderung darstellen.

- Vendor Lock-in: Da NIM eine proprietäre Plattform von Nvidia ist, besteht die Gefahr eines Vendor Lock-ins. Unternehmen, die sich für NIM entscheiden, sind möglicherweise von Nvidias Preisgestaltung und Roadmap abhängig.

Entscheidungskriterien für Unternehmen bei der Auswahl einer Lösung

Angesichts der Vor- und Nachteile von Nvidia NIM im Vergleich zu anderen Lösungen stellt sich die Frage: Wie sollten Unternehmen entscheiden, welche Plattform für ihre spezifischen Anforderungen am besten geeignet ist? Hier sind einige wichtige Kriterien, die bei dieser Entscheidung berücksichtigt werden sollten:

- Komplexität des Anwendungsfalls: Für komplexe KI-Anwendungen mit hohen Anforderungen an Leistung und Skalierbarkeit kann Nvidia NIM die beste Wahl sein. Für einfachere Anwendungsfälle können jedoch auch andere Lösungen ausreichen.

- Technisches Know-how: Unternehmen, die bereits über KI-Experten und Entwickler verfügen, können von der Flexibilität und Leistungsfähigkeit von NIM profitieren. Unternehmen mit begrenztem technischen Know-how sind möglicherweise besser mit einer einfacheren Lösung bedient.

- Budget: Die Kosten für die Nutzung von Nvidia NIM, einschließlich GPU-Ressourcen und Support, müssen gegen die Kosten anderer Lösungen abgewogen werden. Unternehmen mit begrenztem Budget müssen möglicherweise Kompromisse eingehen.

- Integrationsbedarf: Wenn KI-Modelle eng mit bestehenden Unternehmensanwendungen und -systemen integriert werden müssen, kann die nahtlose Integrierbarkeit von NIM ein entscheidender Vorteil sein.

- Vendor-Präferenzen: Einige Unternehmen bevorzugen möglicherweise Lösungen von etablierten Anbietern wie Nvidia, während andere auf Open-Source-Technologien oder Cloud-native Plattformen setzen.

Ein Beispiel für die Entscheidungsfindung

Lassen Sie uns anhand eines konkreten Beispiels veranschaulichen, wie Unternehmen bei der Auswahl einer Lösung für die Bereitstellung von KI-Modellen vorgehen können.

Stellen Sie sich vor, ein mittelständisches Einzelhandelsunternehmen möchte generative KI einsetzen, um personalisierte Produktempfehlungen für seine Online-Shop-Kunden zu erstellen. Das Unternehmen hat ein begrenztes Budget und nur wenige Datenwissenschaftler im Team, aber es verfügt über eine erfahrene IT-Abteilung.

In diesem Fall könnte das Unternehmen wie folgt vorgehen:

- Anforderungen definieren: Zunächst sollte das Unternehmen seine spezifischen Anforderungen an Leistung, Skalierbarkeit und Integration definieren. Für personalisierte Produktempfehlungen sind möglicherweise keine extrem hohen Anforderungen erforderlich.

- Lösungen evaluieren: Anschließend kann das Unternehmen verschiedene Lösungen für die Bereitstellung von KI-Modellen evaluieren, darunter Nvidia NIM, Cloud-Plattformen wie AWS oder Google Cloud, und Open-Source-Frameworks wie Kubeflow.

- Kosten und Ressourcen berücksichtigen: Angesichts des begrenzten Budgets und der verfügbaren Ressourcen kann das Unternehmen entscheiden, dass eine Cloud-basierte Lösung mit vordefinierten KI-Diensten die beste Option ist. Diese erfordert weniger technisches Know-how und hat geringere Einstiegskosten als Nvidia NIM.

- Proof of Concept durchführen: Bevor eine endgültige Entscheidung getroffen wird, kann das Unternehmen einen Proof of Concept mit der ausgewählten Lösung durchführen, um sicherzustellen, dass sie den Anforderungen gerecht wird und die erwarteten Ergebnisse liefert.

- Implementierung und Optimierung: Nach erfolgreicher Evaluierung kann das Unternehmen mit der Implementierung der Lösung in seiner Produktionsumgebung beginnen und die Leistung im Laufe der Zeit optimieren.

Dieses Beispiel zeigt, dass die Entscheidung für oder gegen Nvidia NIM von den spezifischen Anforderungen und Rahmenbedingungen eines Unternehmens abhängt. Während NIM für einige Anwendungsfälle die beste Wahl sein kann, können für andere Szenarien alternative Lösungen besser geeignet sein.

Erste Schritte mit Nvidia NIM: So gelingt der Einstieg

Sie haben in den vorherigen Artikeln dieser Serie viel über Nvidia NIM erfahren – von den Grundlagen der Plattform über Anwendungsfälle und Praxisbeispiele bis hin zum Vergleich mit anderen Lösungen. Aber wie können Sie nun selbst mit NIM loslegen und generative KI in Ihrem Unternehmen einsetzen? In diesem Artikel geben wir Ihnen eine Schritt-für-Schritt-Anleitung für den Einstieg in Nvidia NIM.

Voraussetzungen und Anforderungen

Bevor Sie mit Nvidia NIM loslegen können, müssen Sie sicherstellen, dass Sie die erforderlichen Voraussetzungen und Ressourcen erfüllen. Hier sind die wichtigsten Punkte, die Sie berücksichtigen sollten:

- Hardware: Für den Einsatz von Nvidia NIM benötigen Sie leistungsstarke GPU-Ressourcen. Je nach Anwendungsfall und Skalierungsanforderungen können dies lokale Workstations, dedizierte Server oder Cloud-Instanzen sein.

- Software: NIM setzt auf containerisierte Umgebungen und erfordert daher eine kompatible Container-Plattform wie Docker oder Kubernetes. Zudem benötigen Sie die NIM-Software selbst sowie die erforderlichen Treiber und Bibliotheken für Ihre GPU-Hardware.

- Daten: Generative KI-Modelle erfordern große Mengen an Trainingsdaten. Stellen Sie sicher, dass Sie über geeignete Datensätze verfügen oder die Möglichkeit haben, diese zu beschaffen oder zu generieren.

- Know-how: Für den effektiven Einsatz von NIM sind Kenntnisse in Bereichen wie KI, Datenverarbeitung, Containerisierung und Softwareentwicklung erforderlich. Stellen Sie sicher, dass Ihr Team über das nötige Fachwissen verfügt oder planen Sie entsprechende Schulungen ein.

Schritt-für-Schritt-Anleitung zur Einrichtung von NIM

Sobald Sie die Voraussetzungen erfüllt haben, können Sie mit der Einrichtung von Nvidia NIM beginnen. Hier ist eine Schritt-für-Schritt-Anleitung, die Sie durch den Prozess führt:

- Installation der NIM-Software: Laden Sie die NIM-Software von der Nvidia-Website herunter und installieren Sie sie auf Ihrem System. Folgen Sie dabei den Anweisungen in der Dokumentation.

- Einrichtung der Container-Plattform: Richten Sie eine kompatible Container-Plattform wie Docker oder Kubernetes ein, falls noch nicht vorhanden. Stellen Sie sicher, dass die Plattform korrekt konfiguriert ist und mit NIM zusammenarbeitet.

- Konfiguration der GPU-Ressourcen: Konfigurieren Sie Ihre GPU-Ressourcen für den Einsatz mit NIM. Dies kann die Installation von Treibern, die Einrichtung von CUDA und die Konfiguration von Ressourcen-Pools umfassen.

- Auswahl und Vorbereitung der KI-Modelle: Wählen Sie die generativen KI-Modelle aus, die Sie mit NIM einsetzen möchten. Bereiten Sie die Modelle für die Verwendung mit NIM vor, indem Sie sie in das erforderliche Format konvertieren und die notwendigen Metadaten bereitstellen.

- Erstellung der Container-Images: Erstellen Sie die Container-Images für Ihre KI-Modelle mithilfe der von NIM bereitgestellten Tools und Vorlagen. Stellen Sie sicher, dass die Images alle erforderlichen Abhängigkeiten und Konfigurationen enthalten.

- Bereitstellung und Skalierung der Modelle: Stellen Sie die Container-Images in Ihrer Produktionsumgebung bereit und konfigurieren Sie die Skalierungsoptionen entsprechend Ihrer Anforderungen. NIM bietet Optionen für automatische Skalierung und Lastverteilung.

- Integration in Anwendungen: Integrieren Sie die bereitgestellten KI-Modelle in Ihre Anwendungen und Systeme mithilfe der von NIM bereitgestellten APIs und SDKs. Stellen Sie sicher, dass die Integration nahtlos funktioniert und die erwarteten Ergebnisse liefert.

- Überwachung und Optimierung: Überwachen Sie die Leistung und Auslastung Ihrer KI-Modelle mithilfe der von NIM bereitgestellten Monitoring-Tools. Optimieren Sie die Ressourcennutzung und die Modellkonfigurationen basierend auf den gesammelten Daten.

Tipps und Best Practices

Um den Einstieg in Nvidia NIM zu erleichtern und potenzielle Fallstricke zu vermeiden, hier noch einige Tipps und Best Practices:

- Starten Sie klein: Beginnen Sie mit einem überschaubaren Anwendungsfall und skalieren Sie nach und nach, um Komplexität zu vermeiden und schnelle Erfolge zu erzielen.

- Nutzen Sie vordefinierte Modelle: NIM bietet eine Reihe vordefinierter KI-Modelle, die für gängige Anwendungsfälle optimiert sind. Nutzen Sie diese als Ausgangspunkt, bevor Sie eigene Modelle entwickeln.

- Automatisieren Sie Prozesse: Nutzen Sie die Automatisierungsfunktionen von NIM, um sich wiederholende Aufgaben wie die Aktualisierung von Modellen oder die Skalierung von Ressourcen zu vereinfachen.

- Schulen Sie Ihr Team: Stellen Sie sicher, dass Ihr Team über das nötige Wissen und die Fähigkeiten verfügt, um NIM effektiv zu nutzen. Investieren Sie in Schulungen und fördern Sie den Wissensaustausch innerhalb des Teams.

- Iterieren und optimieren Sie: Betrachten Sie den Einsatz von NIM nicht als einmaliges Projekt, sondern als kontinuierlichen Prozess. Sammeln Sie Feedback, analysieren Sie Daten und optimieren Sie Ihre Modelle und Prozesse kontinuierlich.

Ressourcen und Support von Nvidia

Nvidia bietet eine Vielzahl von Ressourcen und Supportoptionen, um Unternehmen beim Einstieg in NIM zu unterstützen:

- Dokumentation: Die offizielle NIM-Dokumentation bietet detaillierte Anleitungen, API-Referenzen und Best Practices für den Einsatz der Plattform.

- Tutorials und Beispiele: Nvidia stellt eine Reihe von Tutorials, Beispielen und vorkonfigurierten Modellen bereit, die den Einstieg erleichtern und Best Practices demonstrieren.

- Community-Foren: Die Nvidia Developer Community bietet Foren und Diskussionsgruppen, in denen sich NIM-Nutzer austauschen, Fragen stellen und Erfahrungen teilen können.

- Professioneller Support: Für Unternehmen mit spezifischen Anforderungen oder komplexen Anwendungsfällen bietet Nvidia professionelle Supportoptionen, einschließlich dedizierter Ansprechpartner und maßgeschneiderter Lösungen.

Fazit

Der Einstieg in Nvidia NIM mag zunächst komplex erscheinen, aber mit der richtigen Vorbereitung, einer strukturierten Herangehensweise und den richtigen Ressourcen können Unternehmen schnell von den Vorteilen der Plattform profitieren.

Durch die Auswahl geeigneter Anwendungsfälle, die Einrichtung der erforderlichen Infrastruktur und die Integration in bestehende Systeme können Unternehmen generative KI erfolgreich in ihre Prozesse einbinden und neue Möglichkeiten erschließen.

Gleichzeitig ist es wichtig, realistisch zu bleiben und nicht zu viel auf einmal zu wollen. Durch einen schrittweisen Ansatz, kontinuierliche Iteration und die Nutzung der von Nvidia bereitgestellten Ressourcen und Supportoptionen können Unternehmen die Komplexität reduzieren und langfristig Erfolge erzielen.

Wenn Sie noch Fragen zum Einstieg in Nvidia NIM haben oder Erfahrungen teilen möchten, hinterlassen Sie uns einen Kommentar. Wir freuen uns darauf, von Ihren Erkenntnissen zu hören und gemeinsam die Möglichkeiten von generativer KI zu erschließen.

Und wenn Sie bereit sind, den nächsten Schritt zu gehen und NIM in Ihrem Unternehmen einzusetzen, zögern Sie nicht, auf die Ressourcen und Supportoptionen von Nvidia zurückzugreifen. Mit der richtigen Unterstützung und einem engagierten Team können Sie die Vorteile von generativer KI schon bald in Ihrem Unternehmen nutzen.