OpenAI mit ChatGPT-4o einen weiteren Meilenstein in der Entwicklung von KI-Assistenten für Blinde und Sehbehinderte erreicht. In einer Welt, die zunehmend von visuellen Informationen geprägt ist, stehen blinde und sehbehinderte Menschen oft vor großen Herausforderungen. Der Zugang zu Bildern, Videos und anderen grafischen Inhalten kann für sie eine unüberwindbare Hürde darstellen. Doch mit dem Aufkommen von KI-gestützten Assistenztechnologien eröffnen sich neue Möglichkeiten, diese Barrieren zu überwinden.

Die Bedeutung von KI-Assistenten für Blinde und Sehbehinderte

KI-Assistenten haben das Potenzial, das Leben von blinden und sehbehinderten Menschen grundlegend zu verändern. Durch die Analyse von Bildern und die Beantwortung von Fragen können diese Technologien ihnen helfen, visuelle Informationen besser zu verstehen und zu navigieren. Dies ermöglicht es ihnen, selbstständiger zu agieren und aktiver am gesellschaftlichen Leben teilzunehmen.

Ein Beispiel dafür ist die App „Seeing AI“ von Microsoft, die Blinden und Sehbehinderten hilft, ihre Umgebung besser wahrzunehmen. Die App kann Texte vorlesen, Personen erkennen und Objekte identifizieren. Sie verwendet maschinelles Lernen und Bildverarbeitung, um visuelle Informationen in gesprochene Beschreibungen umzuwandeln.

ChatGPT-4o: Ein neues multimodales KI-Modell von OpenAI

Das neue multimodale KI-Modell kombiniert Sprachverarbeitung und Bildanalyse auf innovative Weise. Es kann nicht nur Bilder detailliert beschreiben, sondern auch Fragen dazu beantworten und so ein tieferes Verständnis visueller Inhalte ermöglichen.

ChatGPT-4o baut auf den Erfolgen früherer GPT-Versionen auf, die bereits beeindruckende Fähigkeiten in der Textgenerierung und -verarbeitung gezeigt haben. Durch die Integration von Bildanalyse-Funktionen geht ChatGPT-4o jedoch noch einen Schritt weiter. Es eröffnet neue Möglichkeiten für die Entwicklung von barrierefreien Anwendungen und Hilfsmitteln.

Die Fähigkeiten von ChatGPT-4o wurden bereits in der „Be My Eyes“ App demonstriert, die blinden und sehbehinderten Nutzern kostenlose Unterstützung durch menschliche Freiwillige bietet. Durch die Integration von ChatGPT-4o als „virtueller Freiwilliger“ kann die App nun auch dann Hilfestellung leisten, wenn gerade keine menschlichen Helfer verfügbar sind.

Die Einführung von ChatGPT-4o markiert einen bedeutenden Schritt auf dem Weg zu einer inklusiveren Gesellschaft. Es ist ein Beispiel dafür, wie KI-Technologien genutzt werden können, um die Lebensqualität von Menschen mit Behinderungen zu verbessern. Mit der weiteren Entwicklung und Verbreitung solcher Assistenztechnologien können wir eine Zukunft gestalten, in der jeder Mensch unabhängig von seinen Fähigkeiten Zugang zu Informationen und Teilhabe hat.

Die Funktionsweise von ChatGPT-4o: Ein Blick unter die Haube

ChatGPT-4o ist mehr als nur ein einfacher Chatbot. Es ist ein hochkomplexes KI-System, das Sprachverarbeitung und Bildanalyse auf innovative Weise kombiniert. Doch wie genau funktioniert diese Technologie? Lassen Sie uns einen genaueren Blick auf die Funktionsweise von ChatGPT-4o werfen.

Integration von Sprachverarbeitung und Bildanalyse

Das Herzstück von ChatGPT-4o ist die nahtlose Integration von Sprachverarbeitung und Bildanalyse. Das System verwendet fortschrittliche Machine-Learning-Algorithmen, um sowohl Text als auch Bilder zu verstehen und zu interpretieren. Durch die Kombination dieser beiden Modalitäten kann ChatGPT-4o ein umfassenderes Verständnis von Inhalten erlangen.

Die Sprachverarbeitung in ChatGPT-4o basiert auf dem Transformer-Modell, einer Architektur, die sich besonders gut für die Verarbeitung sequenzieller Daten wie Text eignet. Durch das Training auf riesigen Textdatensätzen hat ChatGPT-4o gelernt, Sprache auf einem nahezu menschlichen Niveau zu verstehen und zu generieren.

Die Bildanalyse in ChatGPT-4o verwendet Convolutional Neural Networks (CNNs), eine Art von neuronalen Netzen, die speziell für die Verarbeitung von Bilddaten entwickelt wurden. CNNs können visuelle Merkmale wie Kanten, Formen und Texturen erkennen und so ein detailliertes Verständnis von Bildern erlangen.

Fähigkeit zur detaillierten Bildbeschreibung und Beantwortung von Fragen

Durch die Kombination von Sprachverarbeitung und Bildanalyse kann ChatGPT-4o Bilder nicht nur erkennen, sondern auch detailliert beschreiben. Das System analysiert verschiedene Aspekte eines Bildes wie Objekte, Personen, Szenen und Aktivitäten und generiert dann eine zusammenhängende textuelle Beschreibung.

Ein Beispiel: Wenn ChatGPT-4o ein Bild von einem Mann sieht, der in einem Park spazieren geht, könnte es eine Beschreibung wie die folgende generieren:

„Das Bild zeigt einen Mann mittleren Alters, der in einem Park spazieren geht. Er trägt eine blaue Jacke, Jeans und braune Schuhe. Der Park ist grün und sonnig, mit Bäumen und einem Weg im Hintergrund. Der Mann scheint einen entspannten Spaziergang zu genießen.“

Zusätzlich zur Beschreibung von Bildern kann ChatGPT-4o auch Fragen zu den dargestellten Inhalten beantworten. Nutzer können beispielsweise fragen: „Welche Farbe hat die Jacke des Mannes?“ oder „Scheint die Sonne in dem Bild?“. ChatGPT-4o analysiert dann das Bild und generiert passende Antworten.

Verbesserungen gegenüber früheren GPT-Versionen

ChatGPT-4o baut auf den Erfolgen früherer GPT-Versionen auf, bietet jedoch signifikante Verbesserungen in Bezug auf Leistung und Fähigkeiten. Einige der wichtigsten Fortschritte sind:

- Erhöhte Genauigkeit: ChatGPT-4o liefert präzisere und detailliertere Beschreibungen von Bildern als seine Vorgänger.

- Besseres Kontextverständnis: Durch die Integration von Sprachverarbeitung und Bildanalyse kann ChatGPT-4o den Kontext von Bildern besser verstehen und interpretieren.

- Erweiterte Fähigkeiten: ChatGPT-4o kann nicht nur Bilder beschreiben, sondern auch Fragen dazu beantworten und so ein interaktiveres Erlebnis bieten.

Mit seiner innovativen Kombination aus Sprachverarbeitung und Bildanalyse setzt ChatGPT-4o neue Maßstäbe in der Welt der KI-Assistenten. Es ist ein mächtiges Werkzeug, das blinden und sehbehinderten Menschen einen besseren Zugang zu visuellen Informationen ermöglicht und so ihre Teilhabe am digitalen Leben verbessert.

ChatGPT-4o im Einsatz: Wie der KI-Assistent blinden Menschen im Alltag hilft

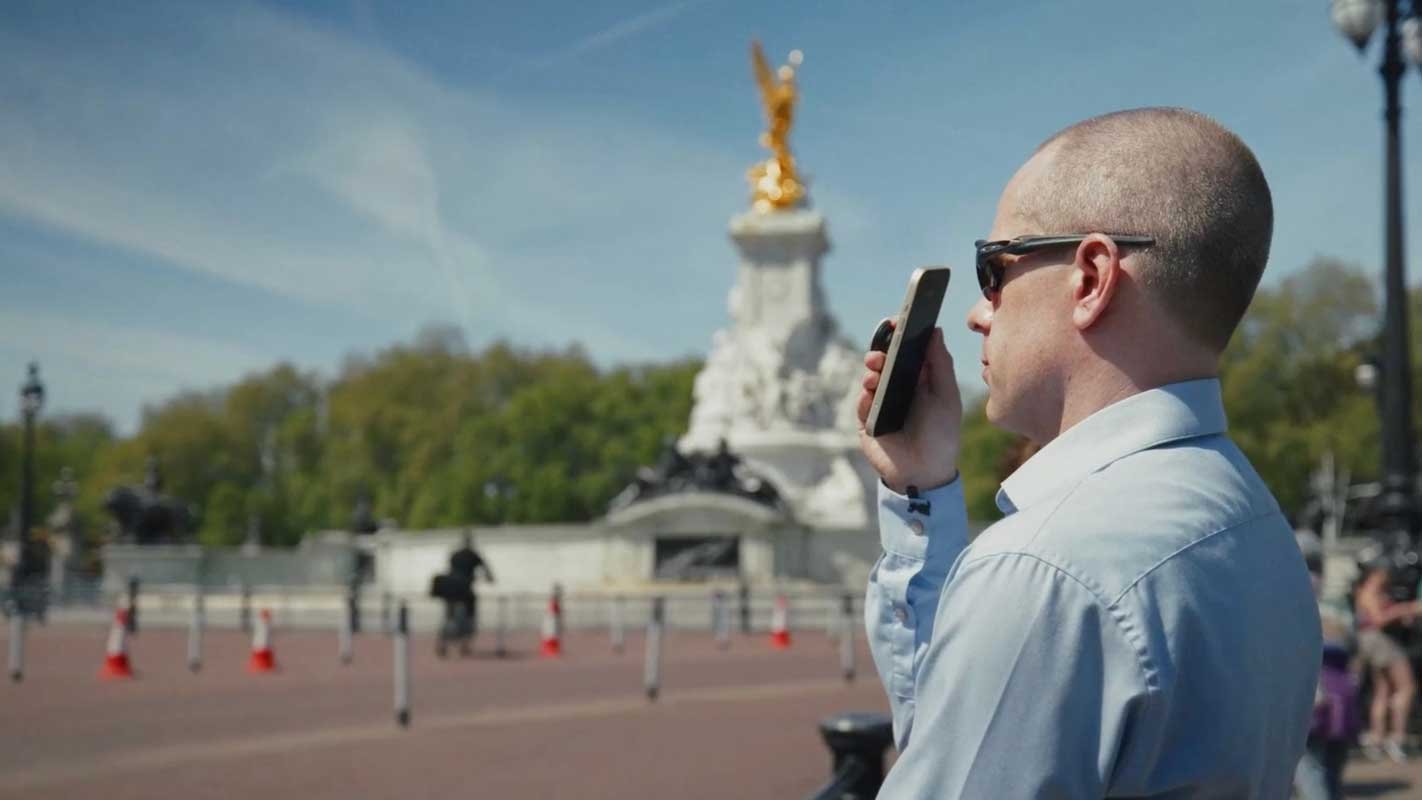

ChatGPT-4o ist nicht nur eine beeindruckende technologische Errungenschaft, sondern auch ein wertvolles Werkzeug für blinde und sehbehinderte Menschen. Durch seine Fähigkeit, Bilder zu beschreiben und Fragen zu beantworten, eröffnet ChatGPT-4o neue Möglichkeiten für die Barrierefreiheit. Lassen Sie uns anhand von konkreten Beispielen sehen, wie ChatGPT-4o im Alltag eingesetzt werden kann.

Integration in die „Be My Eyes“ App

Eines der ersten Projekte, das ChatGPT-4o in der Praxis einsetzt, ist die „Be My Eyes“ App. Diese App verbindet blinde und sehbehinderte Nutzer mit freiwilligen Helfern, die ihnen bei visuellen Aufgaben unterstützen. Durch die Integration von ChatGPT-4o als „virtueller Freiwilliger“ kann die App nun noch mehr Menschen helfen.

Kostenloser „virtueller Freiwilliger“ ergänzt menschliche Helfer

ChatGPT-4o steht den Nutzern der „Be My Eyes“ App rund um die Uhr kostenlos zur Verfügung. Es ergänzt die menschlichen Freiwilligen und stellt sicher, dass immer Hilfe verfügbar ist, auch wenn gerade keine Helfer online sind. Dadurch wird die Zuverlässigkeit und Verfügbarkeit der App deutlich verbessert.

Detaillierte Bildbeschreibungen und Antworten auf Fragen

Wenn ein Nutzer ein Bild an ChatGPT-4o sendet, analysiert der KI-Assistent es und generiert eine detaillierte Beschreibung. Es erkennt Objekte, Personen, Text und andere visuelle Elemente und fasst sie in einer klaren, verständlichen Beschreibung zusammen. Zusätzlich kann der Nutzer Fragen zu dem Bild stellen, die ChatGPT-4o dann beantwortet.

Beispiele für Einsatzmöglichkeiten im Alltag

Die Möglichkeiten, wie ChatGPT-4o in der „Be My Eyes“ App eingesetzt werden kann, sind vielfältig. Hier sind einige Beispiele:

- Produktbeschreibungen: Ein blinder Nutzer kann ein Foto von einem Produkt im Supermarkt an ChatGPT-4o senden und erhält eine detaillierte Beschreibung, einschließlich Marke, Geschmacksrichtung und Nährwertinformationen.

- Kleidungsauswahl: Durch das Senden von Fotos kann ChatGPT-4o blinden Nutzern helfen, Kleidungsstücke nach Farbe, Muster und Stil zu unterscheiden und passende Outfits zusammenzustellen.

- Orientierung: ChatGPT-4o kann Bilder von Straßenschildern, Gebäuden oder Landmarken beschreiben und so blinden Nutzern helfen, sich in unbekannten Umgebungen zurechtzufinden.

Potenzial für den Einsatz in anderen Hilfsmitteln

Die Integration von ChatGPT-4o in die „Be My Eyes“ App ist nur ein Beispiel dafür, wie der KI-Assistent blinden und sehbehinderten Menschen helfen kann. Das Potenzial für den Einsatz in anderen Hilfsmitteln ist enorm.

Denkbar wäre beispielsweise eine Integration in Screenreader-Software, die den Bildschirminhalt für blinde Nutzer vorliest. Durch die Beschreibung von Bildern und Grafiken könnte ChatGPT-4o das Verständnis von Webseiten und Dokumenten verbessern.

Auch in Navigationshilfen wie Blindenleitsystemen oder Orientierungs-Apps könnte ChatGPT-4o zum Einsatz kommen. Durch die Beschreibung von Landmarken, Schildern und Hindernissen könnte es blinden Menschen helfen, sich sicherer und selbstständiger zu bewegen.

ChatGPT-4o ist mehr als nur eine beeindruckende KI-Technologie. Es ist ein Werkzeug, das das Leben von blinden und sehbehinderten Menschen grundlegend verändern kann. Durch seinen Einsatz in Apps wie „Be My Eyes“ und anderen Hilfsmitteln trägt es dazu bei, Barrieren abzubauen und eine inklusivere Gesellschaft zu schaffen.

1 Gedanke zu „ChatGPT-4o: Mehr Barrierefreiheit für blinde und sehbehinderte Menschen“